Мероприятия

Вебинары, митапы и конференции для IT-сообщества. Регистрируйтесь на предстоящие события или смотрите в записи прошедшие.

-

ВебинарКак управлять IT-инфраструктурой в 2026 году: практическое руководство по приручению bare metal

ВебинарКак управлять IT-инфраструктурой в 2026 году: практическое руководство по приручению bare metal -

МитапSelectel Network MeetUp #14

МитапSelectel Network MeetUp #14 -

МитапPitch the Future. Med AI

МитапPitch the Future. Med AI -

МитапSelectel Admin MeetUp

МитапSelectel Admin MeetUp -

ВебинарКак мы строим S3 в Selectel

ВебинарКак мы строим S3 в Selectel -

ВебинарКак соответствовать требованиям локализации персональных данных

ВебинарКак соответствовать требованиям локализации персональных данных -

ВебинарКак использовать Karpenter в Managed Kubernetes

ВебинарКак использовать Karpenter в Managed Kubernetes -

ВебинарКак защитить данные клиентов в корпоративной CRM

ВебинарКак защитить данные клиентов в корпоративной CRM -

Selectel х Продакты СПбProduct MeetUp

Selectel х Продакты СПбProduct MeetUp -

МитапSelectel Python MeetUp

МитапSelectel Python MeetUp -

МитапSelectel UX & Research MeetUp

МитапSelectel UX & Research MeetUp -

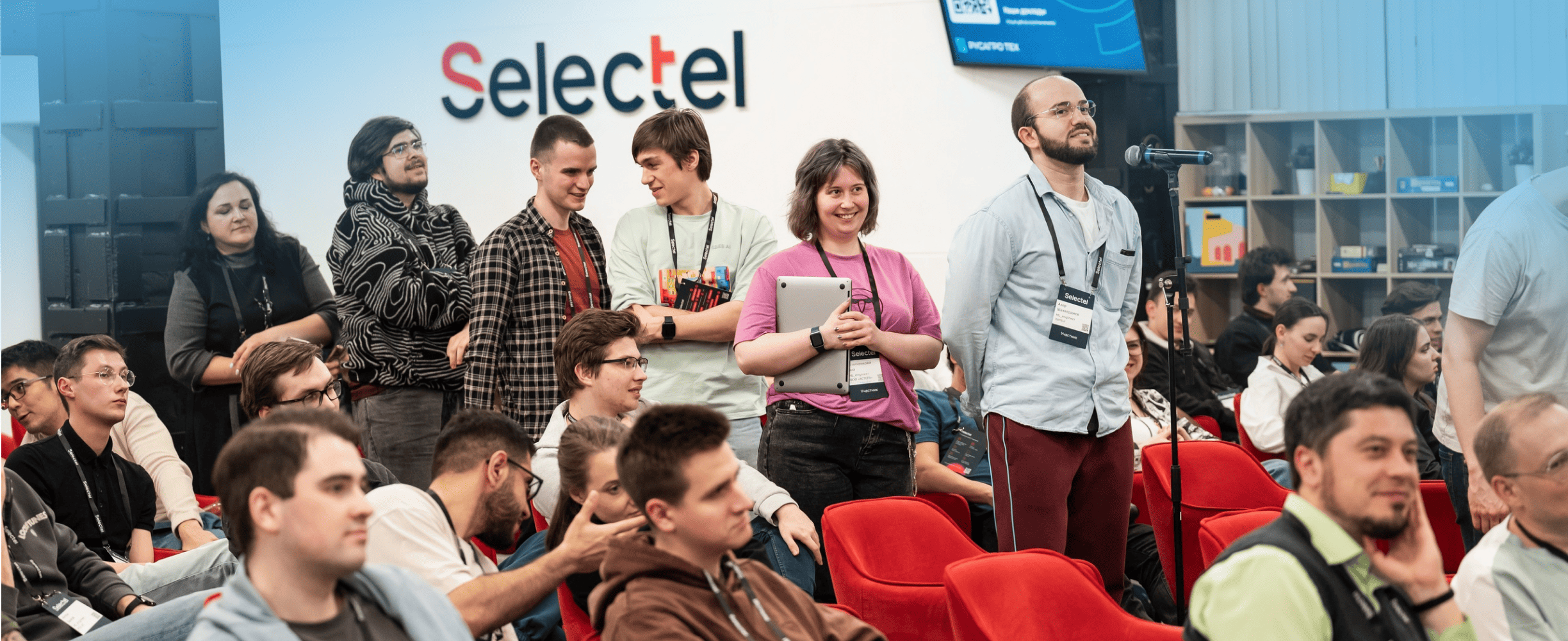

Флагманская конференция SelectelSelectel Tech Day

Флагманская конференция SelectelSelectel Tech Day