Что такое Large Language Model

Большие языковые модели (LLM, Large Language Model) представляют собой продвинутые алгоритмы, обученные на огромных массивах данных. Они способны работать с текстами: анализировать и затем генерировать связные ответы, будто их писал человек.

Когда говорят о LLM, нейронных сетях и искусственном интеллекте, кажется, что это три разных мира. Но так ли это?

Чем LLM отличается от нейронных сетей и ИИ?

На самом широком уровне мы говорим об искусственном интеллекте, который охватывает все технологии, способные выполнять задачи, требующие человеческого интеллекта. ИИ — это не конкретная технология, а целое семейство подходов, включающее статистические методы, ML и нейросети.

Нейронные сети — это более узкое понятие, относящееся к моделям, вдохновленным принципами работы человеческого мозга. Они обучаются на данных и применяются для решения задач разного типа. Например, сверточные нейронные сети (CNN) применяют для анализа изображений, а рекуррентные (RNN) – для работы с временными рядами.

Большие языковые модели (LLM) представляют собой подтип нейронных сетей, специально разработанный для работы с текстовыми данными. Они используют архитектуру трансформеров, которая эффективно обрабатывает большие объемы текстовой информации, сохраняя контекст даже на длинных текстовых последовательностях.

Для каких задач LLM применяются сегодня

LLM находят применение в различных направлениях, помогая автоматизировать и улучшать процессы. Рассмотрим основные области использования LLM.

Генерация текстов и контента. LLM подходят для создания текстов любой сложности — от блогов и маркетинговых материалов до кода. Благодаря умению анализировать стиль и содержание, они генерируют текст, который соответствует конкретным требованиям.

Виртуальные ассистенты. Виртуальные ассистенты на базе LLM помогают решать повседневные задачи, например, организацию дел. Их главная сила — умение работать с расплывчатыми и нечеткими запросами.

Примечание

Нечеткий запрос — это запрос, который формулируется не в строгом виде команды, а как обычное человеческое высказывание, где могут отсутствовать важные детали. Например, «Напомни мне сделать это завтра утром» не содержит точной информации: что именно нужно сделать, когда конкретно и как это связано с другими задачами.

Если такой запрос передать обычному алгоритму, который работает с четкими командами (например, «Установить будильник на 7:30 утра»), он не сможет понять, что делать.

LLM, напротив, обучены на огромных объемах текстов и способны понимать смысловую связь слов. Они анализируют запрос, догадываются о намерениях пользователя (например, «завтра утром» — это начало следующего дня, а «сделать это» относится к недавнему контексту) и выполняют необходимое действие.

Интеллектуальный поиск. LLM расширяют возможности поиска, анализируя смысловые запросы вместо простого сопоставления ключевых слов.

Многоязычный перевод. LLM обеспечивают качественный перевод, учитывая контекст и стилистические особенности текста. Они превосходят традиционные подходы, так как способны адаптироваться к языковым нюансам, например, идиомам или профессиональной терминологии.

Резюмирование длинных текстов. LLM упрощают обработку информации, сокращая объемные документы до кратких резюме, в которых отражены основные идеи.

Чат-боты. Такие боты на основе LLM стали неотъемлемой частью взаимодействия с клиентами. Они могут имитировать человеческое общение, отвечая на запросы.

Популярные продукты на основе больших языковых моделей

Продукты на основе LLM постоянно развиваются. Каждый год появляются новые модели, которые помогают пользователям решать разнообразные задачи.

Список наиболее популярных решений на 2024 год включает:

- ChatGPT от OpenAI (актуальная версия — GPT-4o). Один из самых известных проприетарных продуктов на базе LLM. Он применяется для генерации текстов, ответов на вопросы, помощи в программировании, обучения и многих других задач.

- Google Bard (Gemini). В мае 2023 года Bard использовал модель PaLM 2, а в декабре 2023 года был переведен на более мощную генеративную модель Gemini. В феврале 2024 года Bard начал поддерживать более 40 языков благодаря интеграции с Gemini Pro, что значительно расширило его возможности в обработке различных языков и мультимодальных данных. Эта модель активно используется в бизнесе, науке и образовании для глубокого анализа данных и сложных рассуждений.

- Copilot от Microsoft. Специализируется на помощи разработчикам в программировании. Эту модель можно интегрировать в IDE, чтобы генерировать фрагменты кода, исправлять ошибки и находить оптимальные решения.

- Claude от Anthropic. Инструмент разработан с акцентом на безопасность взаимодействия с пользователем. Эта модель часто используется в корпоративной среде для работы с большими объемами текста, обработки конфиденциальной информации и сложных текстовых анализов.

- GigaChat от Сбера. Российский продукт GigaChat поддерживает более 100 языков и ориентирован на текстовые и мультимодальные запросы. Он отличается от других моделей LLM глубокой адаптацией к русскоязычному контексту и культуре, поэтому лучше остальных понимает и обрабатывает запросы на русском языке.

- Qwen от Alibaba Cloud. Модель Qwen разработана для анализа и генерации сложных текстов. Она активно используется в бизнесе, исследованиях и образовательных проектах, поддерживает мультиязычную работу и легко адаптируется под конкретные задачи.

Ключевые понятия в работе с LLM

В основе работы больших языковых моделей лежит ряд ключевых понятий.

Токены и токенизация. Токен — это минимальная единица текста (слово, часть слова или символ), с которой работает модель. Токенизация — процесс разбиения текста на такие токены, чтобы модель могла их анализировать.

Трансформеры — базовая архитектура LLM, которая с помощью механизма внимания эффективно обрабатывает длинные контексты, выделяя ключевую информацию.

Эмбеддинг — слова представляются в виде числовых векторов, отражающих их значение и связи с другими словами, что помогает моделям понимать контекст.

Предвзятость модели — предвзятость в выводах модели из-за недостатков или дисбаланса данных, которые были использованы для обучения модели.

Интерпретируемость — способность объяснить, как модель пришла к определенному выводу.

Дообучение — процесс обучения модели на специфичных данных, чтобы адаптировать ее для решения узкоспециализированных задач.

Регуляризация — техника, уменьшающая риск переобучения. Она помогает модели лучше обобщать знания и работать на новых данных.

Энтропия — мера неопределенности модели при принятии решений. Высокая энтропия указывает на большую неопределенность, то есть модель испытывает трудности с выбором конкретного ответа или решения. Низкая энтропия, напротив, свидетельствует о большей уверенности модели в своем прогнозе.Промпт — текстовая инструкция или запрос, с которым пользователь обращается к модели. Промпт может содержать исходные данные, конкретное задание, указания по стилю ответа или контекст.

Что нужно для запуска LLM

Создание и поддержка больших языковых моделей — ресурсозатратный процесс, требующий подготовки и выполнения множества шагов. На каждом этапе разработчикам приходится работать с гигантскими объемами информации и рассчитывать на значительные вычислительные мощности. Рассмотрим каждый из этапов.

Датасет и очистка данных

Любая языковая модель начинается с данных. Чем разнообразнее и качественнее текстовая информация, тем лучше результаты. Данные собираются из книг, статей, сайтов и многих других источников.

Сырой материал часто полон ошибок, лишних символов и дублей, поэтому важно провести очистку данных. После этого текст преобразуется в понятную для модели форму — токены. Это слова, их части или даже отдельные символы, которые становятся строительными блоками для обучения модели.

После тщательной подготовки данные делятся на три части: одни будут использоваться для обучения, вторые — для проверки, а третьи — для валидации.

Выбор архитектуры

Когда данные подготовлены, следующим шагом становится выбор архитектуры модели. Архитектура определяет, как модель будет обрабатывать текст, насколько эффективно она сможет выявлять зависимости между словами и строить логичные ответы. Современные LLM обычно используют архитектуру трансформеров, которая способна учитывать контекст каждого слова в предложении.

Также важно определить размеры модели: более компактные варианты подходят для ограниченных ресурсов, а крупные модели требуют мощных серверов и значительных вычислительных мощностей. На этом же этапе настраиваются ключевые параметры, например, количество слоев для каждого измерения.

Обучение с учителем и без

Процесс начинается с так называемого обучения без учителя. На этом этапе модель изучает структуру языка, пытаясь предсказать следующий элемент текста, что помогает ей разобраться в синтаксисе, грамматике и контекстах. Этот процесс напоминает погружение в новый язык без словаря: модель учится замечать закономерности.

После усвоения принципов подключается обучение с учителем. Здесь модель обучают на конкретных примерах, задавая правильные ответы для определенных задач, например, резюмирования текста или классификации. Такой подход позволяет сделать модель более точной и специализированной.

Отладка и дообучение

После обучения модель проходит этап тестирования. Ее проверяют на реальных задачах, анализируя, насколько качественно и быстро она выполняет свою работу. Если выявляются слабые места, модель может быть дополнительно обучена на более узких и специфичных данных.

Немаловажный этап — дальнейшая поддержка. После выхода модели в свет необходимо дообучать ее актуальными данными и постоянно работать над улучшением, основываясь на обратной связи от пользователей.

Как работает LLM

Для полного понимания процесса работы LLM рассмотрим основные этапы, которые проходят модели на пути к созданию сложных ответов и прогнозов.

Как LLM обучается

Обучение LLM строится на задаче предсказания следующего токена. Для этого используется архитектура трансформеров с механизмом внимания, который позволяет модели акцентировать значимость одних элементов текста над другими. Модель изучает огромные объемы текстов из разных источников, чтобы сформировать обобщенные языковые представления.

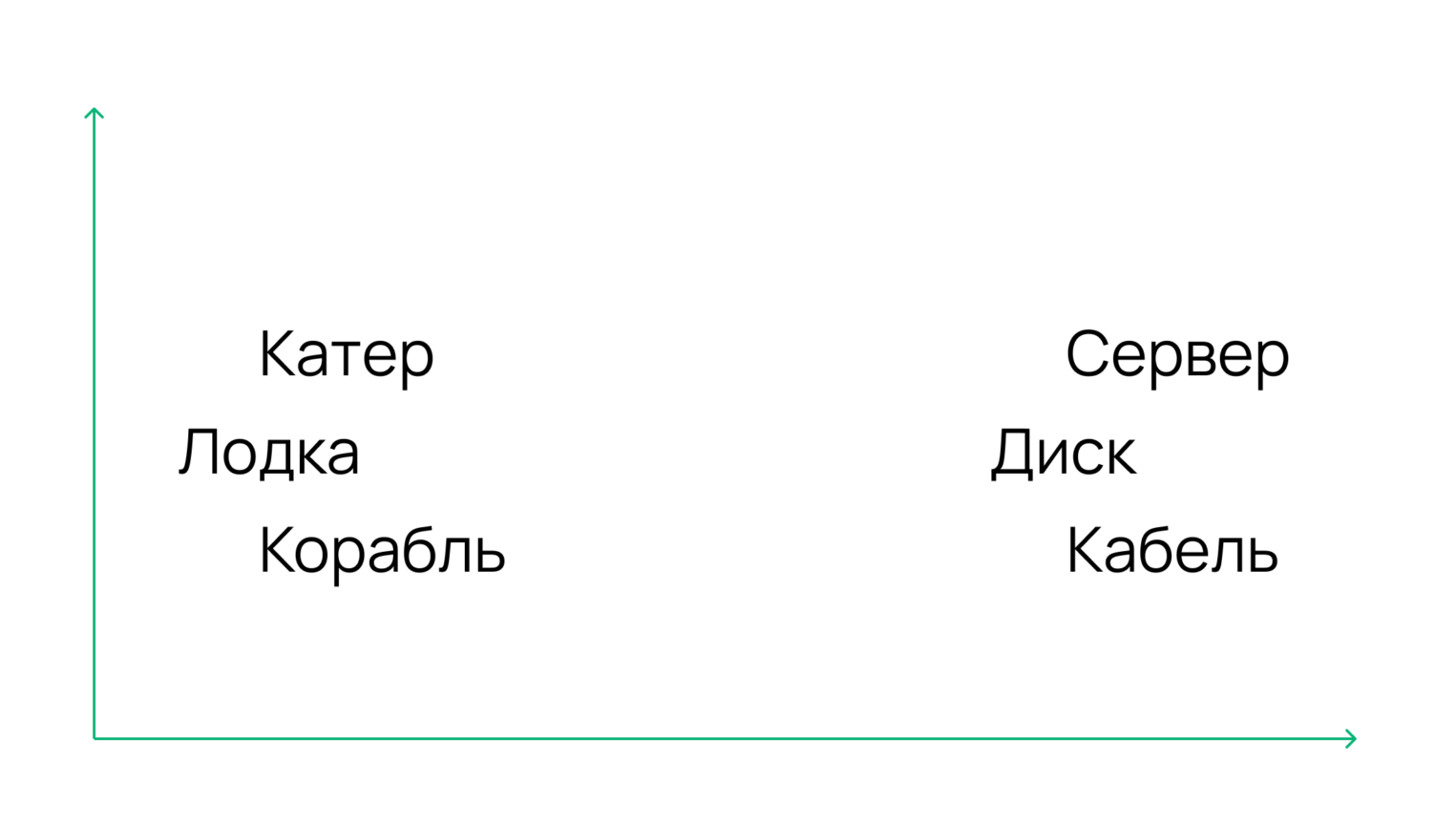

Важный этап — создание векторных представлений (embeddings), которые преобразуют слова и их контексты в многомерные числовые векторы. Например, слова «лодка», «корабль» и «катер» будут находится близко друг к другу, но далеко от слов «сервер», «диск» и «кабель». Такой подход позволяет модели распознавать сходства, различия и связи между словами, формируя основу для понимания языка.

Каждый токен вместе с его вектором и весами внимания проходит через несколько слоев трансформера, где на каждом этапе выявляются зависимости разного уровня. С каждым новым слоем модель все точнее анализирует текст, используя математические методы для поиска связей и закономерностей — от грамматических связей до более сложных абстракций.

Как LLM понимает смысл текста

Используя числовые векторы и механизм внимания, модель выявляет, какие части текста взаимосвязаны и на чем ей стоит сконцентрироваться для правильного восприятия смысла фразы. Например, модель должна понимать, что выражение «Вася подарил Маше цветы» отличается от «Маша подарила Васе цветы». Обе ситуации возможны, но модель должна уметь определять, какой из кейсов имеется в виду, основываясь на контексте.

Одна из ключевых возможностей модели — способность понимать сложные зависимости в длинных текстах, учитывая не только ближайшие слова, но и те, которые находятся далеко друг от друга. Это помогает правильно интерпретировать даже запутанные предложения, где значение слова зависит от удаленного контекста.

Как LLM генерирует текст

Процесс генерации текста строится на пользовательском запросе и связях, выявленных на этапе обучения. На основе этого модель предсказывает следующий токен, который наиболее вероятно соответствует продолжению текста, пока не завершит ответ.

Генерация текста в LLM зависит от настройки параметров, которые управляют разнообразием и качеством ответа. В зависимости от задачи используются разные стратегии.

- Жадный поиск выбирает самый вероятный токен на каждом шаге, что подходит для точных и предсказуемых ответов.

- Семплинг с температурой добавляет элемент случайности: при низких значениях температуры текст становится более осмысленным и естественным, а при высоких — более разнообразным и креативным.

- Стратегии топ-K и топ-P ограничивают выбор токенов: либо оставляют только K наиболее вероятных слов, либо ограничивают выбор суммарной вероятностью P, создавая баланс между логикой и оригинальностью текста.

Ограничения и риски

Использование больших языковых моделей связано с рядом ограничений и рисков, которые важно учитывать.

Недостоверность ответов. LLM могут выдавать информацию, которая выглядит очень правдоподобно, но на самом деле является ложной или выдуманной. Это явление называется «AI-галлюцинацией». Например, модель может придумать факты, ссылки или даже целые концепции, из-за чего важно перепроверять информацию на достоверность.

Проблемы с прозрачностью. Сложная структура и огромный объем данных, на которых обучаются LLM, затрудняют понимание, почему модель дала тот или иной ответ. В таких критически важных областях, как здравоохранение и юриспруденция, это может вызвать значительные риски.

Этические вопросы. Модели могут унаследовать предвзятости или ошибки из данных, на которых они обучались. Это приводит к рискам некорректных ответов или дискриминации. Также существует вероятность того, что модель случайно воспроизведет конфиденциальные данные из обучающего датасета.

Высокие затраты. Работа LLM требует значительных вычислительных ресурсов и затрат электроэнергии. Это делает их дорогими как для разработки, так и для эксплуатации.

Уязвимость к манипуляциям. Злоумышленники могут использовать модель для создания фишингового контента. Например, ее можно обучить стилю общения, характерному для банковских сотрудников, и сгенерировать правдоподобные письма, которые вводят в заблуждение клиентов.

LLM — инструмент с огромным потенциалом, но использовать их нужно осознанно, оценивая риски и предпринимая меры для их минимизации.

Безопасность и защита данных

За каждым запросом, отправленным в модель, могут скрываться конфиденциальные сведения. Чтобы минимизировать риски утечек, важно подходить к этому вопросу комплексно.

Шифрование — это первый щит на пути к защите данных. Каждый байт информации, передаваемый или хранимый, должен быть зашифрован, например, с помощью AES.

Контроль доступа. Только авторизованные сотрудники должны иметь возможность взаимодействовать с чувствительными данными, а многофакторная аутентификация и логирование действий помогают отслеживать и предотвращать возможные нарушения.

Соблюдение стандартов позволяет значительно снизить как юридические, так и репутационные риски. Например, в России компаниям, которые работают с персональными данными, необходимо соответствовать 152-ФЗ. А для компаний, работающих с платежными данными, используется стандарт PCI DSS.

И, конечно, ни одна система не может существовать без постоянного мониторинга. Автоматизированные системы отслеживания угроз, регулярные аудиты и тестирование безопасности — необходимые шаги, чтобы предупредить возможные риски.

Как оценить перспективы использования LLM в продукте

Прежде чем внедрять LLM в свой продукт, важно проанализировать ключевые факторы. Это поможет понять, насколько технология подходит для решения ваших задач.

- Определение целей и задач.

Начните с четкого понимания, какие именно проблемы вы хотите решить с помощью LLM. Планируете ли вы автоматизировать поддержку клиентов, генерировать контент или анализировать данные? Каждая задача требует различных подходов и имеет свои особенности. Понимание этого позволит выбрать оптимальное решение.

- Качество и объем данных для обучения.

Для успешного обучения LLM-моделей требуется значительный объем текстовых данных, которые должны быть качественными, разнообразными и релевантными. Недостаток данных может негативно сказаться на эффективности модели.

- Генерация ложной информации.

LLM может генерировать недостоверные ответы. Задайте себе вопрос: насколько критично для вашего продукта, если пользователь столкнется с подобной проблемой? Если это может нанести серьезный вред, следует подумать над целесообразностью использования LLM в проекте.

- Оценка ресурсов и ожидаемого эффекта.

Перед внедрением LLM оцените не только финансовые, но и временные затраты на настройку, обучение и поддержку модели. Не всегда выгода от улучшения продукта может оправдать затраты на внедрение.

Какие вычислительные ресурсы необходимы для LLM

Создание и поддержка LLM задействуют большое количество ресурсов, чтобы модели могли эффективно обучаться и работать. К ним относятся:

- Вычислительные мощности.

Для обучения LLM используются графические процессоры. Они отлично справляются с параллельными вычислениями, которые необходимы для обработки больших объемов данных. Модели среднего масштаба работают на базе от 8 до 64 GPU, тогда как для гигантов вроде GPT-4 могут понадобиться десятки тысяч графических процессоров..

- Оперативная память.

Модель нуждается в значительном объеме оперативной памяти для хранения промежуточных результатов вычислений и выполнения быстрых операций. Для модели среднего размера обычно требуется от 64 до 128 ГБ RAM. В случае крупных моделей это значение может достигать нескольких терабайт.

- Хранилище данных.

Данные для обучения занимают огромные объемы: до 30 ТБ для средних и сотни ТБ для крупных моделей. Чтобы обеспечить высокую скорость доступа к этим данным, предпочтительно использовать NVMe-накопители.

- Сеть и распределенная обработка.

Для ускорения обучения модели используются кластеры, где тысячи машин соединены сетью с высокой пропускной способностью. Это позволяет распределять задачи и эффективно обрабатывать огромные объемы информации.

Вместо создания собственной инфраструктуры для развертывания LLM, многие компании предпочитают использовать готовые API, например, от OpenAI или Google. Такой подход позволяет быстро интегрировать мощные языковые модели в свои продукты, сервисы и приложения, избегая высоких затрат на покупку и обслуживание оборудования.

Сервисы Selectel для работы с LLM

Весь процесс — от экспериментов с данными до готового продукта — становится проще благодаря сервисам Selectel.

ML-платформа представляет собой преднастроенную инфраструктуру на базе Kubernetes с GPU для обучения и развертывания ML-моделей. Компоненты платформы настроены для работы «из коробки», что позволяет сократить время выпуска новых версий ML-моделей. А единая платформа на базе ClearML позволит проводить эксперименты в рамках общих правил и стандартов.

Inference-платформа основана на open source-решениях для инференса и предназначена для развертывания и масштабирования готовых моделей. Для запуска проекта с помощью Inference-платформы требуется лишь загрузить модель в контейнер объектного хранилища и выполнить несколько команд. Платформа также поддерживает обновление и масштабирование модели, не прекращая обработку пользовательских запросов.

Серверы с GPU — облачные или выделенные — предоставляют мощные ресурсы для обучения и инференса. Получите оффер и разверните идеальное решением для задач любой сложности, включая работу с крупнейшими моделями.

Заключение

Модели на основе LLM открывают большие перспективы в обработке естественного языка, однако успешное внедрение требует глубокого понимания их возможностей и ограничений. При правильном подходе к построению модели, обучению и выбору данных можно достичь желаемых результатов.