GPU

NVIDIA — новое поколение GPU Rubin™

NVIDIA запускает платформу Vera Rubin™ (поколение после Blackwell Ultra), построенную на принципе «extreme codesign» — совместное проектирование железа и софта). Платформа ориентирована на агентный ИИ, MoE-модели и длинный контекст.

Vera Rubin™ — это полноценная системная платформа с шестью ключевыми компонентами:

- NVIDIA Vera™ — Arm-процессор для ИИ-фабрик (88 ядер Olympus, Armv9.2);

- Rubin™ GPU — ускоритель нового поколения с HBM4 и NVLink 6;

- NVLink 6 Switch — коммутатор с жидкостным охлаждением и 400G SerDes;

- ConnectX-9 SuperNIC — сетевой адаптер с поддержкой Ethernet Photonics;

- BlueField-4 DPU — для обработки сетевых и хранилищных задач;

- Spectrum-6 Ethernet Switch — коммутатор для кластерных сетей.

Процессор NVIDIA Vera™ — один из ключевых элементов платформы. Это специализированный Arm-чип для агентных ИИ-нагрузок и крупных ИИ-фабрик.

Как я уже сказал, на борту 88 ядер, и все они кастомные Armv9.2 Olympus с поддержкой пространственной многопоточности. Система работает с внушительным объемом памяти до 1,5 ТБ LPDDR5x, обеспечивая пропускную способность до 1,2 ТБ/с. При этом связка с GPU реализована через интерфейс NVLink-C2C, который выдает 1,8 ТБ/с в дуплексном режиме.

NVIDIA отдельно подчеркивает энергоэффективность Vera и встроенную поддержку конфиденциальных вычислений. Впрочем сегодня это уже не киллер-фича.

GPU Rubin™ ориентирован на обучение и инференс больших моделей с акцентом на низкую разрядность и аппаратное адаптивное сжатие данных.

Основные характеристики:

- производительность: до 50 петафлопсов в FP4 для инференса (в пять раз мощнее Blackwell) и до 35 петафлопсов для обучения;

- память: 288 ГБ HBM4 с пропускной способностью 22 ТБ/с (превосходит Blackwell в 2,8 раза);

- интерконнект: шина NVLink 6 со скоростью 3.6 ТБ/с на каждый GPU (в 2 раза быстрее Blackwell).

Отдельно такие GPU Rubin™ будут представлены в уже традиционных HGX системах.

В максимальной конфигурации Vera Rubin™ NVL72 платформа объединяет 54 ТБ LPDDR5x и 20,7 ТБ HBM4. Агрегированная пропускная способность HBM достигает 1,6 ПБ/с, а интерконнект внутри стойки — 260 ТБ/с, что, по выражению NVIDIA, превышает пропускную способность всего интернета. За такую плотность приходится платить энергопотреблением на уровне 190–230 кВт на стойку.

Отдельного внимания заслуживает NVLink 6 — жидкостно охлаждаемый коммутатор с 400G SerDes, обеспечивающий полносвязную коммуникацию между всеми GPU в стойке.

Вместе с Rubin NVIDIA представила и новую инфраструктуру хранения контекста инференса — Inference Context Memory Storage Platform.

Она построена на BlueField-4 и предназначена для совместного использования и повторного применения KV-кеша в агентных ИИ-нагрузках. По сравнению с традиционными сетевыми хранилищами такая платформа обеспечивает пятикратный прирост токенов в секунду, лучшую производительность на единицу затрат и более высокую энергоэффективность.

Хотя NVIDIA заявляет о начале полномасштабного производства Rubin, серверные решения от партнеров ожидаются во второй половине года. Традиционно в новостях интерес к топовой платформе заявляют крупные игроки рынка.

А чтобы не зависеть от графиков поставок и начать работу над своими проектами можете присмотреться к текущим флагманам. Мы как раз приготовили парк машин с конфигурацией NVIDIA B300.

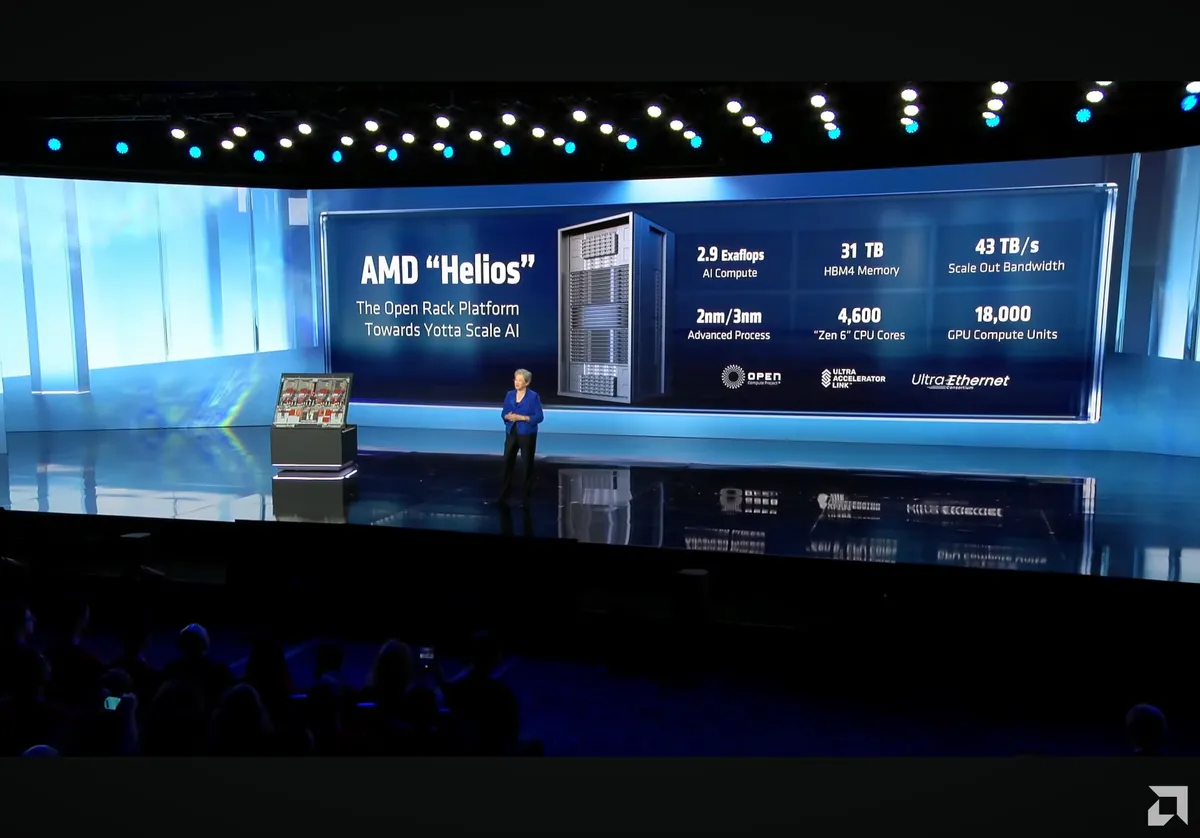

AMD Helios™ — стоечное решение с новыми GPU AMD Instinct MI455X

На CES 2026 AMD раскрыла детали своей новой стоечной ИИ-платформы Helios, а также представила ускорители следующего поколения Instinct MI430X, MI440X и MI455X, которые войдут в семейство MI400-series. Компания позиционирует эту линейку как универсальный набор решений для ИИ.

Helios стала первой rack-scale системой AMD для высокопроизводительных вычислений. Платформа построена на процессорах EPYCTM Zen 6 (Venice), а в максимальной конфигурации объединяет 72 ускорителя Instinct MI455X. Совокупный объем памяти HBM4 в стойке достигает 31 ТБ при агрегированной пропускной способности до 1,4 ПБ/с.

По расчетам AMD, Helios способна обеспечить до 2,9 экзафлопс в FP4 для инференса и до 1,4 экзафлопс в FP8 при обучении ИИ-моделей. При этом компания сразу оговаривается, что система рассчитана на современные ИИ-дата-центры с соответствующими требованиями к питанию и охлаждению.

Помимо флагманского MI455X, AMD подтвердила расширение всего семейства Instinct MI400X. Новые ускорители будут построены на вычислительных чиплетах, произведенных по 2-нм техпроцессу TSMC (N2), что делает MI400X первыми GPU, использующими этот класс литографии. Еще одно важное изменение — впервые ускорители Instinct будут разделены на несколько подсемейств внутри одной архитектуры, поскольку MI400X будет реализован в разных вариантах CDNA 5.

Таким образом, AMD явно уходит от подхода «один ускоритель для всех сценариев», предлагая линейку от отдельных GPU с PCIe-подключением до интегрированных стоечных решений уровня Helios. В 2026 году, судя по заявлениям компании, «свой» Instinct MI400X найдется практически для любой задачи ИИ.

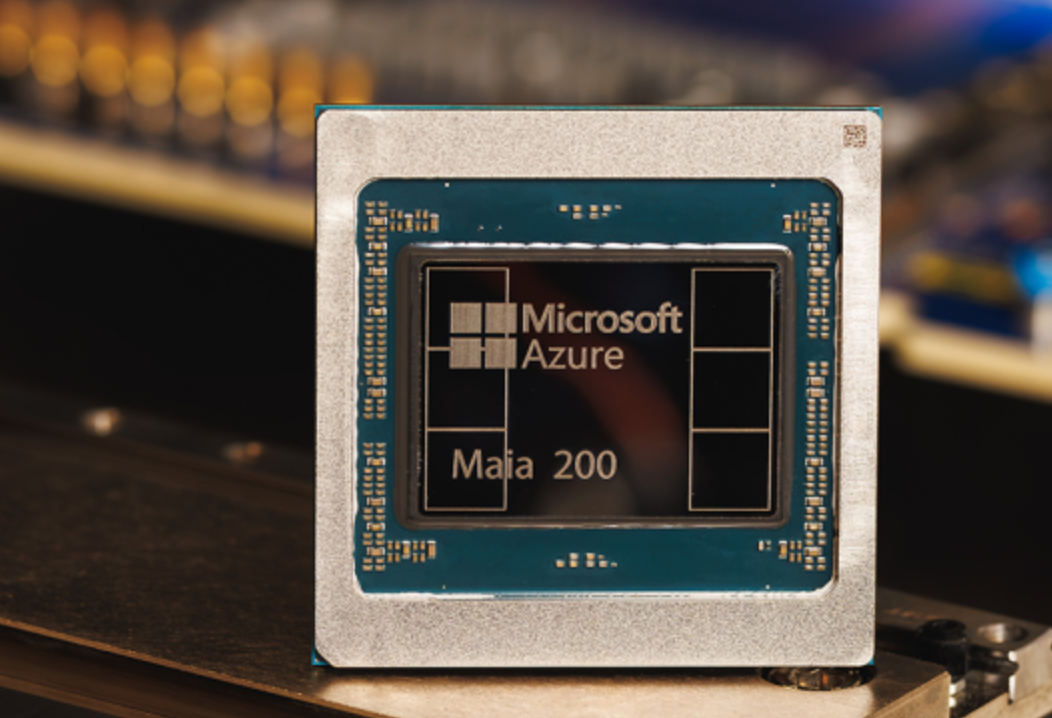

Microsoft Maia 200 — GPU для инференса

Microsoft представила собственный ИИ-ускоритель Maia 200, выполненный по 3-нм техпроцессу и ориентированный исключительно на инференс масштабных моделей. Это уже второе поколение ускорителей линейки.

Ключевые характеристики Maia 200:

- 3-нм техпроцесс;

- собственные тензорные ядра с поддержкой FP8/FP4;

- 216 ГБ HBM3e с пропускной способностью до 7 ТБ/с;

- 272 МБ SRAM;

- более 140 млрд транзисторов;

- TDP 750 Вт, с системой жидкостного охлаждения.

По производительности Maia 200 демонстрирует более десяти петафлопсов в FP4, что почти вдвое ниже показателей NVIDIA Blackwell. В формате FP8 ускоритель обеспечивает свыше пяти петафлопсов, уступая Blackwell примерно в два раза. Таким образом, Microsoft явно делает ставку не на абсолютный максимум производительности.

На уровне системы Maia 200 использует необычно простую для современных ИИ-кластеров схему масштабирования. Вместо проприетарных интерконнектов применяется двухуровневая унифицированная сетевая фабрика на базе стандартного Ethernet. Специальный транспортный уровень Maia AI, а также тесно интегрированный сетевой адаптер позволяют обходиться без собственных высокоскоростных шин.

В практических сценариях Maia 200 станет частью гетерогенной ИИ-инфраструктуры Microsoft и будет использоваться для работы с различными моделями, включая GPT-5.2 от OpenAI. Ускорители задействуют в Microsoft Foundry и Microsoft 365 Copilot, а команда Microsoft Superintelligence планирует применять Maia 200 для генерации синтетических данных и обучения с подкреплением, ускоряя подготовку и фильтрацию специализированных датасетов для моделей следующего поколения.

Zhenwu 810E — GPU с 96 ГБ памяти HBM2e на борту

Подразделение T-Head Semiconductor, входящее в Alibaba Group, представило собственный ИИ-ускоритель Zhenwu 810E.

Чип позиционируется как универсальное решение для обучения и инференса ИИ-моделей, а также для ресурсоемких задач вроде автономного вождения. Важный момент — и аппаратная, и программная архитектуры разработаны внутри T-Head без опоры на внешние платформы.

Для масштабирования используется проприетарный интерконнект ICN (Inter-Chip Network). Каждый чип имеет семь таких интерфейсов для прямого соединения с другими ускорителями, а суммарная пропускная способность достигает 700 ГБ/с.

Ключевые технические особенности Zhenwu 810E:

- собственная аппаратно-программная архитектура T-Head;

- память 96 ГБ HBM2e;

- проприетарный интерконнект ICN;

- до 700 ГБ/с межчиповой пропускной способности;

- 7 ICN-линков на чип;

- интерфейс подключения PCIe 5.0 x16.

По заявлениям, Zhenwu 810E превосходит ускоритель NVIDIA A800 и способен конкурировать с NVIDIA H20. Эта модель, специально адаптированная для китайского рынка под экспортные ограничения США.

Alibaba уже активно использует Zhenwu 810E для обучения собственных больших языковых моделей Qianwen, а также для ИИ-инференса в облаке.

Кроме того, на базе этих ускорителей сервисы предоставляются национальным клиентам, например Государственной электросетевой компании Китая (SGCC), Китайской академии наук и производителю электромобилей Xpeng.

Iluvatar CoreX — GPU «убийцы» NVIDIA

Китайский стартап Iluvatar CoreX, по данным DigiTimes, раскрыл амбициозную дорожную карту по выпуску GPU-ускорителей для ИИ, рассчитанных на прямую конкуренцию с решениями NVIDIA. Компания планирует вывести на рынок сразу четыре поколения архитектур, охватывающих период с текущего момента и как минимум до 2027 года.

Текущие разработки Iluvatar CoreX основаны на архитектуре с кодовым названием Tianshu. По заявлениям компании, ускорители на ее базе уже превосходят по производительности GPU NVIDIA поколения Hopper, включая H200. Эти чипы позиционируются как решения для обучения и инференса в дата-центрах и рассчитаны на крупные ИИ-кластеры.

Дальнейшая дорожная карта выглядит еще агрессивнее:

- начало и середина 2026 года Tianxuan — ускорители, ориентированные на конкуренцию с NVIDIA Blackwell, включая B200;

- конец 2026 года Tianji — архитектура следующего поколения, которая, по утверждениям Iluvatar CoreX, должна превзойти Blackwell по производительности;

- 2027 год Tianquan — GPU, нацеленные на опережение платформы NVIDIA Rubin™.

После Tianquan компания планирует сместить фокус на разработку «прорывных вычислительных архитектур».

На практике стартап уже нельзя назвать чисто экспериментальным. По состоянию на 30 июня 2025 года Iluvatar CoreX отгрузила более 52 000 GPU примерно 290 корпоративным клиентам;

Помимо дата-центровых GPU, Iluvatar CoreX развивает и направление периферийных вычислений. В этой линейке компания разрабатывает чипы Tongyang, предназначенные для edge-сценариев. По утверждению стартапа, один из таких процессоров — TY1000 — в реальных нагрузках превзошел NVIDIA Jetson AGX Orin, включая задачи компьютерного зрения, обработки естественного языка и ИИ-инференса с крупными языковыми моделями уровня DeepSeek 32B.

Очень громкая и амбициозная новость, однако даже такому крупному игроку, как AMD, не удалось разрушить гегемонию NVIDIA. Заявления стартапов с существенно меньшим объемом производства и ограниченными технологиями на этом фоне выглядят вызывающе. Пожелаем удачи и оценим успехи через год.

Deepx — GPU ускорители в виде карты расширения

Южнокорейский стартап Deepx представил сразу три ускорителя на базе собственного узла Genesis NPU. Новинки — DX-H1 V-NPU, DX-H1 Quattro и DX-M — были показаны на CES 2026 и ориентированы на разные сценарии.

Модель DX-H1 V-NPU рассчитана прежде всего на обработку видеопотоков — декодирование, кодирование и перекодирование с одновременным инференсом. Deepx утверждает, что по сравнению с GPU-решениями при той же плотности каналов устройство позволяет снизить стоимость оборудования примерно на 80%, а энергопотребление до 85%.

Ключевые характеристики DX-H1 V-NPU:

- низкопрофильная карта PCIe 3.0 x16 (x8 по линиям);

- два аппаратных видеокодека и два NPU;

- до 50 TOPS (INT8) при инференсе в реальном времени;

- декодирование до 64 каналов H.264/H.265 (1 080p, 30 к/с), кодирование до 32 каналов H.264/H.265 (1 080p, 30 к/с);

- память — 16 ГБ LPDDR5 для видеокодеков и 8 ГБ для NPU;

- интерфейс HDMI 2.0, eMMC-накопитель на 32 ГБ;

- максимальное энергопотребление — 40 Вт.

Ускоритель DX-H1 Quattro ориентирован на более универсальные ИИ-задачи в дата-центрах и на периферии. Здесь ставка сделана не на видео, а на вычислительную плотность и энергоэффективность.

Основные параметры DX-H1 Quattro:

- карта расширения PCIe 3.0 x16;

- четыре NPU с суммарной производительностью до 100 TOPS (INT8);

- 16 ГБ LPDDR5;

- энергопотребление 20 Вт.

Самым компактным решением в линейке стал DX-M1 M.2 — ИИ-ускоритель для встраиваемых и edge-систем:

- выполнен в формате M.2 2280;

- производительность до 25 TOPS;

- энергопотребление не выше 5 Вт;

- интерфейс PCIe 3.0 x4;

- поддержка систем на базе x86 и Arm.

Deepx явно делает ставку на нишу, где GPU избыточны по энергопотреблению и цене: видеоаналитика, edge-ИИ и компактные серверные системы. Линейка DX-H1 и DX-M1 выглядит как попытка занять промежуточное место между классическими CPU серверами и системами с «тяжелыми» GPU-ускорителями.

Диски

Seagate — HDD на 32ТБ

Seagate вывела на рынок жесткие диски объемом 32 ТБ сразу в трех линейках — SkyHawk AI, IronWolf Pro и Exos. Все модели выполнены в форм-факторе LFF, используют традиционную магнитную запись CMR в сочетании с HAMR и подключаются по SATA 6 Гбит/с. Фактически это максимальный на сегодня объем для серийных HDD Seagate, рассчитанных на круглосуточную работу.

Устройства обладают общими характеристиками:

- объем 32 ТБ;

- скорость передачи данных до 285 МБ/с;

- скорость вращения шпинделя — 7 200 оборотов в минуту (для IronWolf Pro и Exos);

- герметичная гелиевая камера;

- MTBF до 2,5 млн часов.

SkyHawk AI ориентирован на системы видеонаблюдения с аналитикой. Диск рассчитан на одновременную запись до 64 HD-видеопотоков и обработку до 32 ИИ-потоков. Используются технологии минимизации потерь кадров при интенсивной записи и ускорения восстановление массива после сбоев.

IronWolf Pro предназначен для NAS-систем и многодисковых хранилищ. Это диск с расчетной нагрузкой до 550 ТБ в год. В этой линейке также есть технология, которая отвечает за балансировку, корректную работу RAID и снижение энергопотребления.

За состоянием накопителя следит IronWolf Health Management, обеспечивающая проактивный мониторинг и рекомендации по эксплуатации.

Серверную линейку представляет Seagate Exos — диск для дата-центров с непрерывной нагрузкой. Для случайного доступа заявлены до 170 IOPS на чтение и 350 IOPS на запись (4K, QD16). У дисков оптимизируется энергопотребление, что может быть важно при плотных стойках и масштабировании.

Для дисков с увеличенным объемом важен показатель стоимости за ТБ. По данным Seagate, по этому параметру диски могут быть конкурентоспособны.

Сетевое оборудование

Panmnesia Panswitch — чип-коммутатор для HPC вычислений

Южнокорейский стартап Panmnesia продемонстрировал чип-коммутатор Panswitch (H1SW06245ACFAA), созданный для HPC-платформ в дата-центрах для задач ИИ. Вместе с ним представлена плата для разработчиков PanRDK, предназначенная для тестирования и прототипирования CXL-систем.

Ключевая особенность Panswitch — полная поддержка спецификации CXL 3.2, включая Port-based Routing (PBR). По заявлению компании, это первое решение в своем классе, что позволяет объединять тысячи CXL-устройств в единую вычислительную среду.

Основные характеристики и функции:

- полная поддержка CXL 3.2, включая Port-based Routing (PBR);

- построение масштабируемых CXL-фабрик с подключением тысяч устройств;

- поддержка различных топологий: древовидные (tree), ячеистые (mesh), Dragonfly и другие HPC-архитектуры;

- проприетарный CXL-контроллер Panmnesia со сверхнизкой задержкой;

- поддержка интерфейса PCI Express 6.4;

- оптимизация путей передачи данных под конкретные ИИ-нагрузки.

Panmnesia сообщает, что поставки чипов Panswitch и пилотных систем уже начались, что делает платформу доступной для ранних внедрений и экспериментов с CXL-фабриками нового поколения.

MikroTik — коммутатор с размещением двух устройств в один юнит

MikroTik представила L3-коммутатор CRS804 DDQ, ориентированный на небольшие ИИ и HPC-инфраструктуры.

Устройство выполнено в форм-факторе 1U половинной ширины, что позволяет размещать два коммутатора в одном юните стойки.

Ключевые характеристики

- ASIC: Marvell 98DX7335;

- CPU: 4-ядерный Arm Annapurna Labs AL52400 (до 2 ГГц);

- память: 4 ГБ RAM, 512 МБ NAND;

- порты: 4 × QSFP56-DD (400 Гбит/с), 2 × 10GbE RJ45, консольный порт RJ45;

- 2 БП с горячей заменой (100–240 В);

- энергопотребление до 123 Вт.

Ориентировочная стоимость MikroTik CRS804 DDQ составляет от 1 300$, что делает его одним из самых доступных устройство с 400G-портами для задач ИИ начального и среднего уровня.

Заключение

Мир GPU инфраструктуры эволюционирует — NVIDIA задает темп с платформой Vera Rubin, AMD отвечает стоечным решением Helios, Microsoft делает ставку на инференс. Китайские игроки активно осваивают нишу конкурентных GPU. Параллельно растет и «вспомогательная» инфраструктура: Seagate выводит HDD на 32 ТБ для ИИ-нагрузок, а Panmnesia прокладывает путь для масштабируемых CXL-фабрик.

Для заказчиков это значит больше выбора, гибкости и, возможно, снижения затрат. А для нас — возможность предложить клиентам по-настоящему разные решения. Мы по прежнему продолжаем следить за новинками железа, оставайтесь с нами.