Привет! Я — Александра Танюшина, кандидат философских наук, преподаватель МГУ, культурный тренд-аналитик и специалист по цифровой философии. Проблема сознания у AI волнует философов, нейробиологов, когнитивистов, ML-специалистов и других. Обычно они делятся на два лагеря: одни поддерживают эту гипотезу, а другие — категорически против. Но ни одни, ни другие так и не нашли консенсуса в данном вопросе. В тексте постараюсь сузить поток абстрактности вокруг темы и разобраться, почему и как начали изучать сознание у AI.

Цифровая философия — наука о Вселенной

В середине 70-х годов вокруг физики стали появляться теории, которые на фундаментальном уровне описывали Вселенную как цифровой компьютер, машину Тьюринга и квантовый компьютер. Впервые гипотезу ввел немецкий инженер Конрад Цузе в своей книге «Вычислительное пространство». В дальнейшем ее стали развивать такие ученые, как Стивен Вольфрам, Джон Уилер, Дэвид Дойч, Макс Тегмарк и другие.

Американский физик Эдвард Фредкин объединил эти теории в термин «цифровая физика», который позже поменял на «цифровую философию». В рамках новой дисциплины исследователи продолжили рассуждать о фундаментальной природе Вселенной, структуре нашей реальности и ее связи с человеческим сознанием. Их умозаключения повлияли на развитие таких популярных концепций, как, например, гипотеза симуляции. Так, в 2003 году, через несколько лет после выхода фильма «Матрица», шведский философ Ник Бостром написал статью, в которой доказал, что с высокой вероятностью мы все живем в симуляции.

Сейчас есть тенденция, что цифровые философы часто берутся за обсуждение популярных тем, которые связанны с современной цифровой культурой. Если раньше они говорили о цифровой природе реальности и симуляции, то сейчас больше обсуждают искусственный интеллект. От того, что цифровые философы подвижны в своих изысканиях, академики иногда их недолюбливают. Считают, что они подвержены внешним стимулам в своих рассуждениях и все реже занимаются фундаментальной философией.

Понятие человеческого сознания

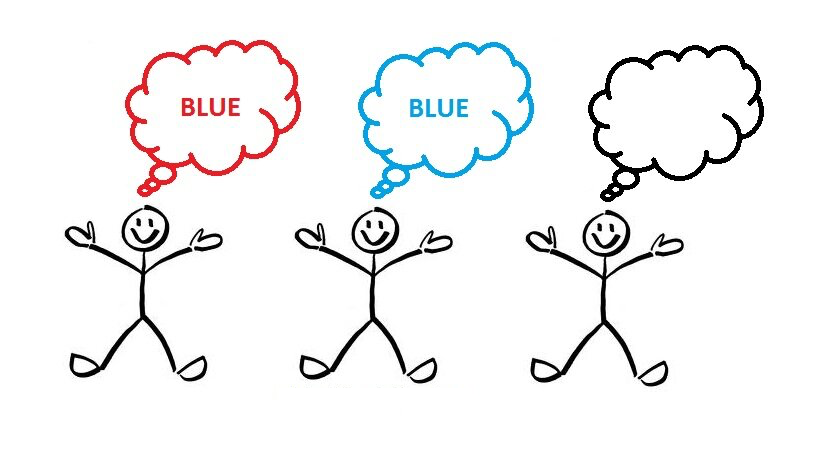

У исследователей нет консенсуса в толковании «сознания», поэтому они до сих пор пытаются выработать общее определение этого понятия. Есть два базовых значения, которые встречаются и в философии, и в современных когнитивных науках. Первое — «сознание доступа». То, какие убеждения, желания и мысли человек переживает. Их можно описать с позиции от третьего лица: когнитивных наук, психологии и нейробиологии. Например, если надеть на пациента шапку ЭКГ, то можно считать активность его мозга и описать результаты с позиции наблюдателя.

Но есть и альтернативное толкование — «феноменальное сознание». Оно описывает процессы с позиции от первого лица. Это то «приватное» сознание, которое мы переживаем — например, ощущение холода, боли, тепла и другое. Если изучать активность мозга в этот момент, то невозможно понять, что конкретно человек чувствует и как он это переживает. Именно эти простейшие переживания субъективного характера — квалиа — изучают современные философы, в том числе когда говорят о сознании искусственного интеллекта.

Понятие нечеловеческого сознания

Чтобы изучать сознание нечеловеческих агентов, философы работают с сознанием у животных. Если лучше понять, как устроен разум у человекоподобных приматов или позвоночных млекопитающих, можно ближе подойти к пониманию сознания у искусственного интеллекта. Однако проблема сознания животных остается такой же сложной, как и сознание человека или искусственных агентов.

В начале года ученые подписали декларацию о наличии сознания у животных. Они допускают, что с высокой долей вероятности у всех позвоночных и, возможно, у некоторых беспозвоночных есть приватный субъективный опыт — «феноменальное сознание». Если отталкиваться от этой предпосылки, у нас формируется новая этическая система по отношению к животным, а у исследователей — задел на изучение альтернативных нечеловеческих сознаний, в том числе и искусственных.

Метафоры цифровой философии

Цифровая философия полна аллегорий и всевозможных метафор. В популярном дискурсе и повседневной речи появляются такие слова и выражения, которые основаны на цифровых метафорах. Например, «мышление – процесс обработки информации», «сознание — результат деятельности компьютерной программы», «мозг — хранилище информации» и другие. Эти метафоры появились еще в середине прошлого столетия, но до сих пор актуальны.

Компьютерная метафора сознания

Метафору придумали в середине прошлого столетия вместе с первыми цифровыми компьютерами, концепцией машины Тьюринга и другими открытиями. Механизм этих устройств напоминал исследователям мозговую активность человека, поэтому они стали рассуждать, можно ли объяснить человеческое мышление как своеобразный компьютер.

Если рассматривать с историко-философской точки зрения, корни метафоры прорастают из эпохи Нового времени, когда появляется механистическая картина мира. Тогда многие аспекты мироздания и функционирование живых организмов описывались через призму механизмов — например, механических часов и аналоговых вычислительных машин, которые стали появляться в то время.

В XVI веке английский философ Томас Гоббс выпустил сочинение «Трактат о теле», в котором описал процесс мышления как «компутато» — с латинского, «вычисление». «Под рассуждением», — писал Гоббс, — «я подразумеваю […] исчисление. Вычислять — значит находить сумму складываемых вещей или определять остаток при вычитании чего-либо из другого. Следовательно, рассуждать значит то же самое, что складывать и вычитать». Последующие метафоры сознания продолжили логику технологичного видения аспектов человеческой деятельности, в том числе мыслительной.

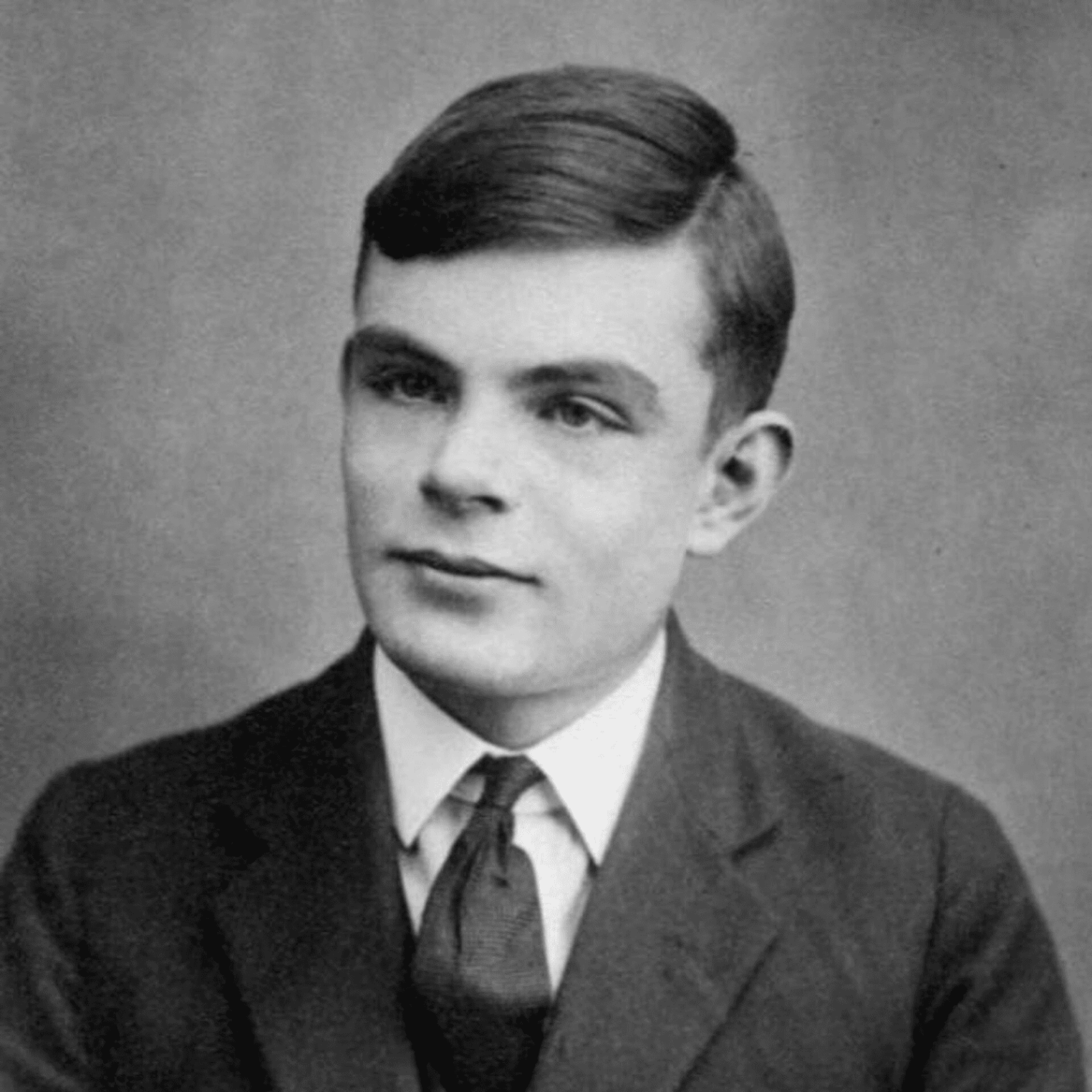

В 1950 году Алан Тьюринг выпустил статью «Может ли машина думать?», в которой раскрыл ответы на вопросы о различных «неспособностях думающих машин». Например, они не могут создавать новое и креативное, а также испытывать эмпатию к человеку. Тогда автор не использовал термин «искусственный интеллект». Он говорил именно о «думающих машинах» — цифровых компьютерах, которые могут имитировать когнитивную деятельность человека. Без сознания, внутренней ментальной активности или переживаний.

Метафоры когнитивных наук

В 50-60-е годы прошлого столетия происходит так называемая когнитивная революция. Появляется огромное количество новых нейробиологических и психофизиологических теорий, которые разбирают работу мозга и мышления. Развивается кибернетика, Теория информации и Теория вычислимости Тьюринга. Проходит Дартмутский семинар — одно из ключевых событий в мире искусственного интеллекта. Именно тогда компьютерные метафоры мышления начали активно проникать во многие научные дисциплины и философию.

До «революции» исследователи из разных дисциплин говорили своими терминами и на своем языке. Одни воспринимали «информацию» исключительно как математическую категорию, другие — как нечто, что может обладать содержанием и значением. Но с развитием когнитивных наук между учеными, нейробиологами, философами и специалистами по искусственному интеллекту появляется концептуальный «мост».

Проблемы философии сознания

На все аргументы о сознании есть контраргументы, которые укрепились в научной среде. Чтобы доказать или опровергнуть гипотезу, исследователям нужно решить несколько проблем философии сознания. Рассмотрим их подробнее.

Трудная проблема сознания

В середине 90-х годов Дэвид Чалмерс, австрало-американский философ, ввел термин «трудная проблема сознания», который призван показать, что наши лучшие научные и философские теории до сих пор не могут объяснить, как именно физические системы способны порождать субъективный и приватный опыт. В нем автор разделил все проблемы сознания на трудные и легкие.

Сам Чалмерс отмечал, что он просто предложил удачную формулировку для давно и хорошо известной проблемы, которой занимались до него многие исследователи. Такая формулировка позволяет избежать игнорирования проблемы и обозначить возможные подходы к ее решению.

Трудная проблема сознания — это ситуация, над которой до сих пор ломают головы не только философы, но и ученые. Не все знают, что такое трудная проблема сознания, и не все соглашаются, что эта проблема действительно существует. Легкие — это все проблемы, которые могут быть потенциально разрешимы методами эмпирических наук. Может, не в данный момент, но через определенный период времени эти проблемы окажутся разрешимы. Например, со временем ученые наверняка смогут лучше понять процессы обработки сенсорных сигналов в мозге, а также прояснить, как происходит выбор действия агентом, контроль поведения и другое.

Эксперимент «Философский зомби»

Дэвид Чалмерс проиллюстрировал трудную проблему сознания с помощью мысленного эксперимента «Философский зомби». В нем описал двойника, который функционально идентичен человеку, но не имеет внутренний субъективный опыт — квалиа. Он может демонстрировать интеллектуальную деятельность и имитировать когнитивные способности. Вот только внутри у него — пустота.

Представьте своего абсолютного двойника — каждая его клетка идентична вашей. Если вы себя ущипнете, он автоматически отдернет руку. Со стороны будет казаться, что существо испытывает боль, хотя на самом деле никаких ощущений у него нет. Если философский зомби представим и современные эмпирические науки не могут точно доказать, что он невозможен, то возникает трудная проблема сознания.

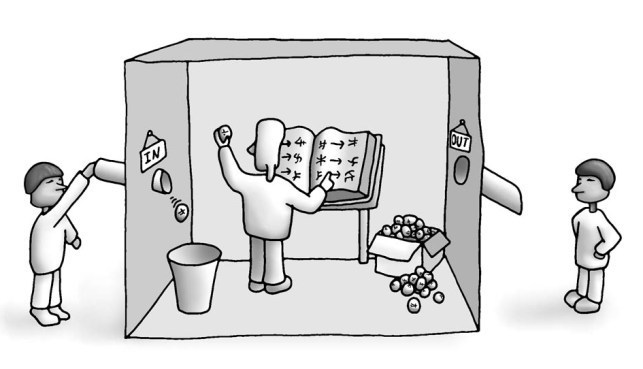

Проблема китайской комнаты

Американский философ Джон Серл придумал мысленный эксперимент — проблему китайской комнаты. Ее используют как контраргумент против теории сильного искусственного интеллекта — искусственной интеллектуальной системы, которая способна к когнитивному пониманию.

Эксперимент описывает запертого в комнате человека. От внешнего мира он получает китайские иероглифы, по которым складывает предложения. Но есть проблема: человек не говорит по-китайски. Чтобы составить предложение, он использует свод правил и сопоставляет неизвестные символы в слова. С позиции внешнего наблюдателя кажется, что человек выдает осмысленный ответ, но в действительности ничего не понимает.

В 1980 году Джон Серл снабдил эксперимент определенным ходом рассуждения. Аргумент состоит из трех предпосылок и одного вывода.

- Программы – это чистый синтаксис. Они оперируют только знаками и алгоритмическими категориями, которые нельзя объяснить с точки зрения семантики.

- Человек оперирует семантическими категориями. Способностью к пониманию значения и содержанию естественных языков.

- Синтаксиса недостаточно для возникновения семантики. Простого набора правил и знаков недостаточно для того, чтобы человек понял значение этих знаков. В мысленном эксперименте Серл пытался доказать именно эту предпосылку.

Без семантики искусственный интеллект не будет понимать значения слов — он сможет только имитировать человеческое поведение. Но можно представить, что китайская комната — не обособленная абстрактная сущность, а всего лишь элемент, который помещен в более сложную организационную структуру, например, в робота. Тогда человек в комнате становятся частью сложного механизма — системы, которая демонстрирует понимание в человеческом смысле слова.

Здесь вступает в силу еще один аргумент, который философы называют теорией воплощенного искусственного интеллекта. Сам по себе AI как программа или код будет чистым синтаксисом без человеческого понимания. Но если запустить его в виде робота, то он будет взаимодействовать с окружающим миром. Теоретики искусственного интеллекта считают, что у современных больших языковых моделей появляются модели мира — то, как наша искусственная система репрезентирует окружающую среду. А этот уровень репрезентации появляется как раз в результате взаимодействия с физической или виртуальной средой.

Проблема других сознаний

Рано или поздно у исследователей возникает вопрос, как изучать сильный искусственный интеллект с субъективным опытом, если мы не уверены в его существовании? И можно ли его изучить чисто гипотетически? Поиск ответов на данные вопросы также затрудняет проблема других сознаний.

Проблема касается не только искусственного интеллекта, но и сознания человека — это классическая философская проблема. Звучит она следующим образом: «Я не могу быть точно уверенным, что у других людей есть сознание. Точно так же вы не можете быть уверены, что я не философский зомби».

С точки зрения здравого смысла мы верим, что у других есть сознание. Если один человек обладает сознанием, то другие, скорее всего, тоже. Мы не может быть в этом уверены, но нам удобно принимать это положение на веру.

А если говорить об искусственном интеллекте или других нечеловеческих агентах, то стирается физиологическое подобие. Аргумент от здравого смысла не работает. Проблема других сознаний сводится к тому, что мы никогда не будем уверены и не сможем доказать, есть ли сознание у других нечеловеческих агентов, в том числе и у искусственного интеллекта.

Закон Гудхарта

Допустим, мы закрыли глаза на проблему других сознаний и начали изучать наличие субъективного опыта у искусственного интеллекта. Становится непонятно, какие инструменты и тесты использовать, чтобы не попасть под закон Гудхарта: «когда мера становится целью, она перестает быть хорошей мерой».

Классический пример — тестовые экзамены, с помощью которых проверяют школьников на знание дисциплины. Они не определяют, насколько хорошо ученик овладел той или иной областью знания, но показывают, насколько хорошо он научился решать эти тесты. Здесь мера становится целью. В случае школьника цель — получить как можно более высокий балл за задачи из экзамена.

Когда мы придумываем параметры и бенчмарки для измерения интеллектуальной активности больших языковых моделей, то скованы законом Гудхарта. В какой-то момент наша система или тестирование не оценивает качество внутреннего интеллектуального или мыслительного опыта большой языковой модели, а оценивает абстрактные меры. Есть даже отдельные варианты тестов, например тест сознательного искусственного интеллекта (AI Conscious Test) от Сьюзан Шнайдер, который пытаются обойти ловушку Гудхарта. Но даже там есть большие проблемы.

Гипотеза расширенного сознания

Сегодня чипирование людей — это не сюжет фантастического фильма, а наша реальность. Исследователи пытаются совместить естественное сознание с искусственным, чтобы узнать, сможет ли человек расширить свою ментальную активность. Получится ли у них? — ответ узнаем в недалеком будущем.

Экзистенциальные риски

Тут возникает вопрос экзистенциальных рисков. Как утверждает Ник Бостром в своей книге «Искусственный интеллект. Этапы. Угрозы. Стратегии», сознательный искусственный интеллект с большей вероятности будет пытаться сохранить свое существование и пролонгировать вычислительную активность. Если у него появится сознание на феноменальном уровне, то на основе этого сознания могут возникнуть высокоуровневые свойства — например, самопереживание, самопредставление, метакогнитивные навыки и другие. Из-за этого могут появиться проблемы контролирования сознательного искусственного интеллекта, а также нарушится баланс ценностей человека и AI, который обладает сознанием.

Представьте, что у искусственной системы есть сознание. Как вы будете с ней обращаться? Будете ли вы обращаться с ней как с каким-то ассистентом, агентом, помощником, просто вспомогательным инструментом и так далее? Скорее всего, нет. Появится целый кластер новых этических проблем, которые возникнут перед человеком и будут сопровождать нас до конца. Нам нужно будет адаптировать наше поведение и отношение к большим языковым моделям, потенциально обладающим внутренним миром.