Docker: что это такое и как работать с контейнерами

Объясняем, зачем нужен Docker, из чего состоит и какую роль играет в связке с Kubernetes, а также как запустить первый контейнер.

Что такое Docker и зачем он нужен

Docker — это платформа с открытым исходным кодом для автоматизации разработки, доставки и развертывания приложений. Ее основная идея — создание стандартного и предсказуемого окружения, где приложения могут работать независимо от операционной системы или инфраструктуры. Docker широко применяется в сферах разработки ПО, DevOps и управления IT-инфраструктурой. Благодаря нему можно ускорить разработку и упростить перенос приложений между окружениями.

Этот инструмент актуален, когда есть запрос на повышение производительности и гибкости. Он предоставляет мощные инструменты для масштабирования приложений, улучшает управление зависимостями и сокращает время развертывания. Благодаря универсальности и простоте использования Docker стал стандартом в современном IT-ландшафте.

Что такое контейнер в Docker

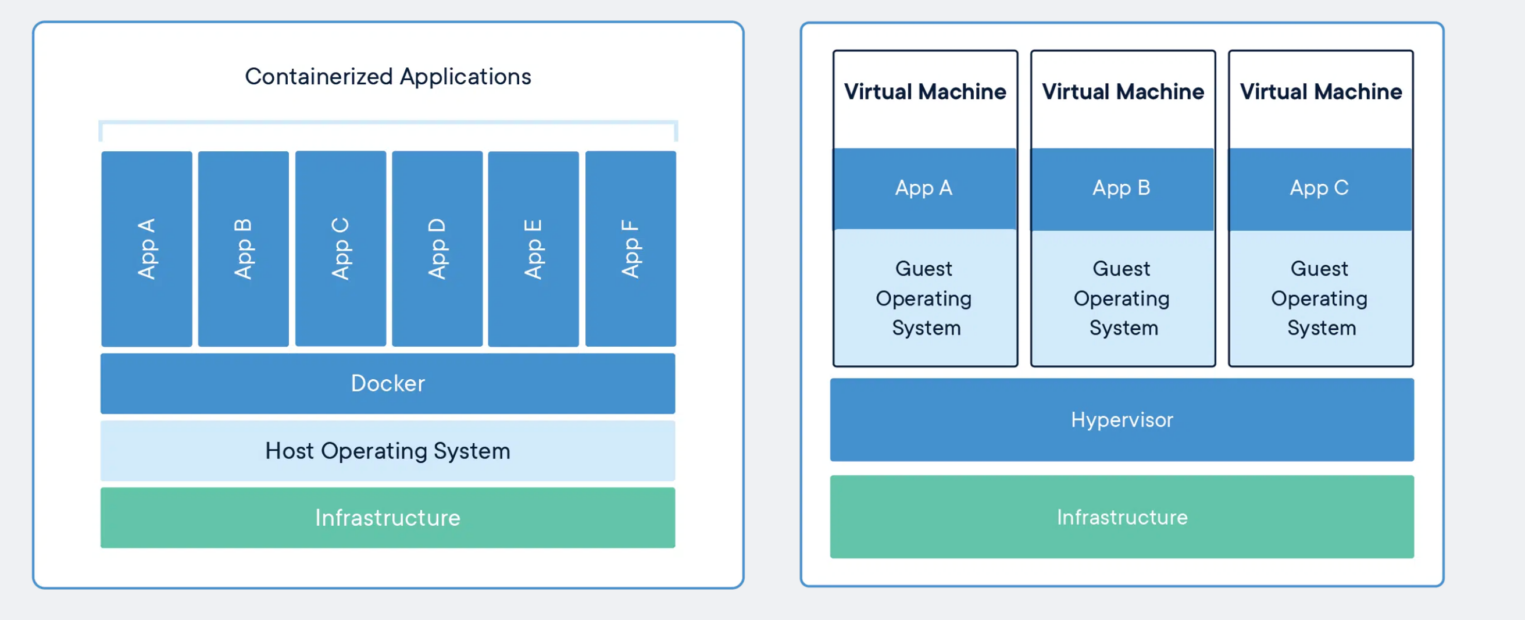

Контейнер — это изолированное пространство, которое позволяет запускать приложения с их зависимостями отдельно от основной системы. Контейнеры используют образы для создания своих окружений. Это делает их легкими, портативными и удобными для управления. Благодаря такому подходу обеспечивается высокая степень изоляции процессов, что позволяет избегать конфликтов между различными версиями библиотек или сервисов. В отличие от традиционных виртуальных машин, контейнеры потребляют меньше ресурсов, так как используют ядро основной системы.

Как работает Docker: основные принципы и технологии

Docker обеспечивает изоляцию приложений, создавая отдельные пространства для их работы. Каждый контейнер использует образы, которые запускаются в изолированном окружении, но при этом работают на общем ядре операционной системы. Это достигается за счет использования технологии виртуализации на уровне ядра.

Docker применяет инкрементную файловую систему, где каждый контейнер состоит из слоев. Каждый слой добавляет изменения или новые данные к базовому образу, что экономит место и ускоряет развертывание. Благодаря этому контейнеры можно легко обновлять, модифицируя только нужные слои.

Контейнеризация основывается на создании образов, которые содержат все необходимое для работы приложения: библиотеки, зависимости и настройки. Контейнеры запускаются мгновенно, обеспечивая согласованность между средами разработки, тестирования и продакшена. Это упрощает процесс управления сервисами и ускоряет их развертывание.

Основное отличие контейнеризации от виртуализации заключается в уровне изоляции. Виртуальные машины используют гипервизор для эмуляции полной операционной системы, что требует значительных ресурсов. Контейнеры же разделяют общее ядро системы, что снижает их вес и улучшает производительность, особенно при работе в облаке.

Преимущества и недостатки: что важно знать

Docker предлагает множество преимуществ для разработки и эксплуатации приложений. Среди ключевых плюсов — изоляция контейнеров, что предотвращает конфликты между зависимостями, легкость управления образами (image) и их хранение в реестре (registry). Кроме того, использование общей системы слоев снижает объем занимаемого хранилища, а быстрое развертывание контейнеров ускоряет разработку. Инструмент отлично подходит для DevOps-процессов и обеспечивает простоту масштабирования в облаке.

Однако у инструмента есть и недостатки. Контейнеры зависят от ядра операционной системы, что может ограничивать использование определенных технологий. Также для работы в сложно организованной серверной инфраструктуре может потребоваться дополнительное ПО для оркестрации, например Kubernetes. Еще одним вызовом является управление безопасностью, особенно при использовании сторонних образов из общедоступных реестров, таких как Docker Hub.

Сравнение Docker и Kubernetes

Docker и Kubernetes решают разные задачи. Первый используется для создания и управления контейнерами, обеспечивая их изоляцию и быструю настройку. Kubernetes, в свою очередь, занимается оркестрацией, помогая управлять множеством контейнеров, распределяя нагрузку и поддерживая высокую доступность сервисов. Вместе эти инструменты создают мощную экосистему для DevOps-инфраструктуры.

Основные компоненты Docker: разбираем архитектуру

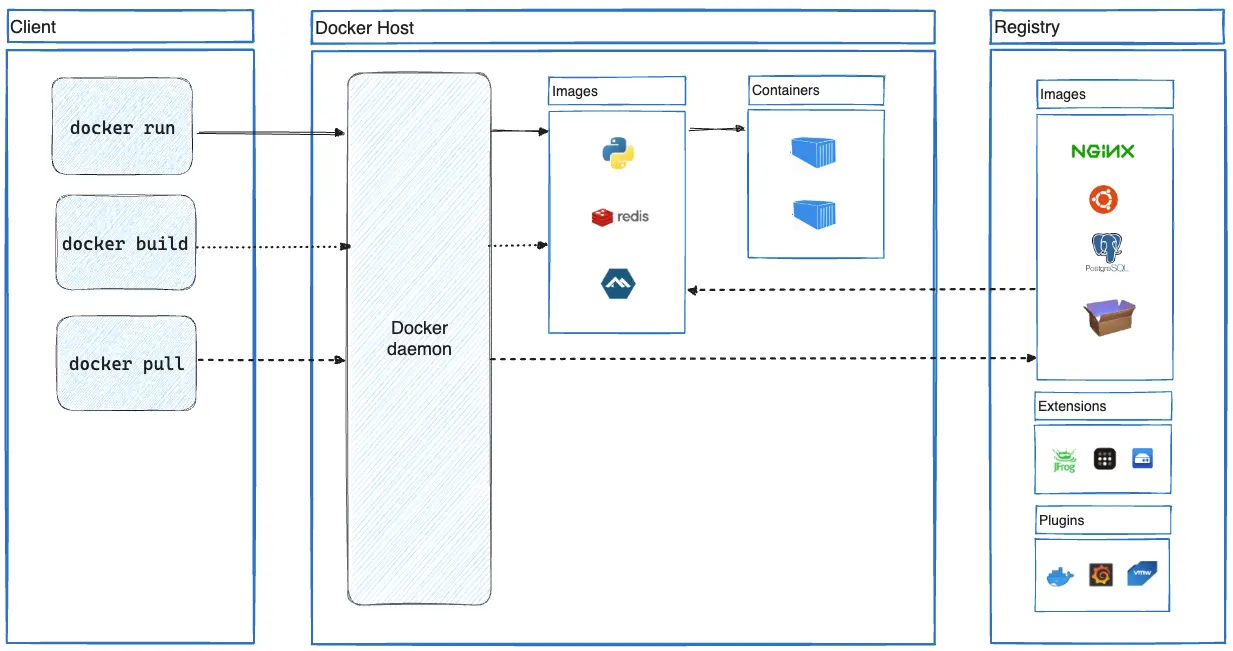

Первый компонент, с которым вы столкнетесь, — это Dockerfile. Это текстовый файл, содержащий инструкции для сборки образа (image). На основе этих инструкций создается финальный образ.

Daemon (демон) — это основной процесс, отвечающий за управление контейнерами, образами и другими ресурсами. Он работает в фоновом режиме и выполняет команды, передаваемые клиентом. Чтобы удобно взаимодействовать с системой, пользователь может использовать интерфейс командной строки — Client (клиент). Например, команды docker run или docker build передаются демону через клиента.

Шаблон, содержащий все необходимое для запуска приложения, называется Image (образ). Он может включать в себя программный код, различные библиотеки и зависимости проекта. Из образов создаются контейнеры.

В свою очередь Container (контейнер) — это изолированное окружение, созданное на основе образа. В нем запускается приложение, используя ресурсы основной системы.

Для хранения образов используется хранилище — Registry (реестр). Самый популярный реестр — это Docker Hub, где можно найти как публичные, так и приватные образы.

Приложение для работы с платформой на локальном компьютере называется Docker Desktop. Оно предоставляет удобный интерфейс для управления контейнерами, образами и другими ресурсами, включая интеграцию с Docker Hub.

Основные задачи Docker: как он упрощает работу с приложениями

Одна из основных задач — это развертывание приложений в среде разработки. Платформа позволяет быстро разворачивать приложения в любом окружении, обеспечивая стабильную работу за счет использования образов (image).

Контейнеры гарантируют изоляцию процессов, что позволяет избежать конфликтов между версиями библиотек или сервисов. Запуск процессов в изолированной среде гарантирует отсутствия конфликтов со внешними сервисами.

Docker также осуществляет контроль ресурсов. Он предоставляет возможность ограничивать доступ контейнеров к ресурсам, таким как процессор, память и дисковое пространство.

Повышение безопасности является первостепенной задачей для любого публичного проекта. Изоляция контейнеров и использование проверенных образов из реестров, таких как Docker Hub, значительно снижают риски утечек данных и уязвимостей.

Это идеальный инструмент для микросервисной архитектуры, упрощая управление и развертывание множества небольших сервисов. Каждый сервис можно обернуть в контейнер. Это обеспечивает как контроль и безопасность для отдельных компонентов системы, так и удобство эксплуатации этих сервисов с технической точки зрения.

Контейнеры запускаются за секунды, что позволяет разработчикам быстрее тестировать и внедрять изменения. Ускорение цикла разработки положительным образом влияет на развитие проекта и бизнеса в целом.

Docker обеспечивает удобное управление инфраструктурой сложных систем, особенно в связке с инструментами оркестрации, например Kubernetes. Кроме того, контейнеры легко масштабируются, что позволяет эффективно распределять нагрузку и обеспечивать высокую доступность сервисов.

Эти возможности делают Docker универсальным инструментом для управления приложениями на всех этапах жизненного цикла — от разработки до масштабирования в облаке.

Создание и запуск контейнеров на облачном сервере

Чтобы запустить приложение через Docker на облачном сервере, потребуется минимальная подготовка инфраструктуры. В первую очередь, необходимо установить его на сервер. Данное ПО поддерживается основными популярными ОС: Windows, Mac и Linux. Инструкцию об установке можно найти на официальном сайте. Большинство современных облачных провайдеров предоставляют готовые образы виртуальных машин с предустановленным Docker.

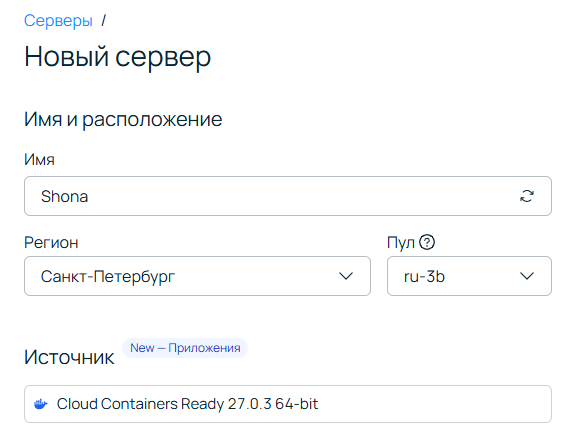

Например, в панели управления Selectel на этапе конфигурирования облачного сервера в разделе Источник выберите Cloud Containers Ready. Это приложение с настроенной ОС Ubuntu 22.04. Оно содержит:

- Docker версии 27.0.3,

- плагины для запуска Docker Compose версии 2.11.1,

- Portainer версии 2.20.3 — графический интерфейс для мониторинга и управления Docker-контейнерами, образами и сетью Docker.

Если вы устанавливаете все самостоятельно, убедитесь, что Docker Daemon запущен и доступен для выполнения команд. Также потребуется доступ к реестру образов, например, Docker Hub, где можно найти готовые образы популярных приложений или загрузить свой.

Для запуска приложения важно иметь заранее подготовленный docker-compose.yml файл (если приложение состоит из нескольких сервисов) или команду для запуска конкретного контейнера. Это упростит настройку портов, переменных окружения и ограничений по ресурсам.

Создание своего образа через Dockerfile

Если стандартные образы из реестра не подходят для ваших задач, можно создать свой собственный образ с помощью Dockerfile. Этот файл описывает инструкции для создания образа, включая базовый образ, команды для установки зависимостей и копирования файлов проекта. Пример простого Dockerfile:

FROM python:3.9

WORKDIR /app

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

COPY . .

CMD ["python", "app.py"]

В этом примере используется официальный образ Python версии 3.9. Команда COPY requirements.txt добавляет файл зависимостей в контейнер, а затем выполняется их установка с помощью pip install. После этого проект копируется в контейнер, и запускается основной скрипт приложения app.py.

Чтобы создать образ, выполните команду:

docker build -t my-python-app .Полученный образ можно использовать для развертывания контейнера или загрузить в Docker Hub с помощью команды docker push. Это позволит использовать образ на любом сервере с Docker.

Запуск образа в облаке

Собранный образ можно развернуть на облачном сервере, используя команду:

docker run -d -p 5000:5000 my-python-appЭта команда запускает контейнер из образа my-python-app, «маппит» локальный порт 5000 на порт контейнера и выполняет приложение в фоновом режиме (-d).

Если приложение использует дополнительные сервисы, такие как базы данных, или состоит из нескольких микросервисов, удобно применять docker-compose. Этот инструмент позволяет легко управлять зависимостями и автоматизировать запуск контейнеров, упрощая развертывание и масштабирование Python-приложений в облачной среде.

Список полезных команд

Вот небольшая шпаргалка с важными командами для управления контейнерами.

Посмотреть список всех запущенных контейнеров

docker psЭта команда отображает информацию о всех запущенных контейнерах, включая их ID, имя, статус, порты и используемый образ. Если хотите увидеть все контейнеры (включая остановленные), используйте docker ps -a.

Остановить и удалить все контейнеры

docker stop $(docker ps -aq) && docker rm $(docker ps -aq)Первая часть команды останавливает все контейнеры, вторая — удаляет их. Флаги -q возвращают только ID контейнеров, что удобно для массовых операций.

Запустить контейнер с последующим удалением

docker run --rm <image_name>Флаг –rm автоматически удаляет контейнер после завершения его работы. Это полезно для временных задач, когда нет необходимости сохранять контейнер.

Посмотреть список всех скачанных образов

docker imagesКоманда отображает список всех доступных локальных образов, их версии и размеры. Если образ занимает слишком много места, можно использовать команду docker system prune для очистки неиспользуемых данных.

Удалить образ

docker rmi <image_id_or_name>Команда удаляет образ по его ID или имени. Убедитесь, что ни один контейнер не использует образ, иначе команда завершится с ошибкой.

Получить список всех контейнеров, созданных из определенного образа

docker ps -a --filter "ancestor=<image_name>"Флаг –filter “ancestor=<image_name>” отфильтровывает контейнеры по указанному образу. Фильтры можно комбинировать — например, искать контейнеры по статусу и образу одновременно.

Эти команды помогут эффективно управлять контейнерами и образами, а также оптимизировать рабочие процессы.