Количество дата-центров в мире выросло с 500 тыс до более чем 8 млн всего за десять лет. И все они потребляют около 3–5% всего электричества планеты. В результате каждый дата-центр косвенно провоцирует выбросы парникового газа в атмосферу — суммарно около 2% от мировых выбросов CO2. Это примерно столько же, сколько выбрасывают крупнейшие авиакомпании мира.

В интересах провайдеров потреблять энергию эффективно, без лишних выбросов, чтобы снизить техногенное влияние дата-центров на внешнюю среду и оптимизировать затраты на электричество. Для этого необходимо следить за значением PUE собственных дата-центров и улучшать его при необходимости. Что это за параметр и как мы в Selectel заботимся об энергоэффективности, рассказываем в статье.

Энергоэффективность и показатель PUE

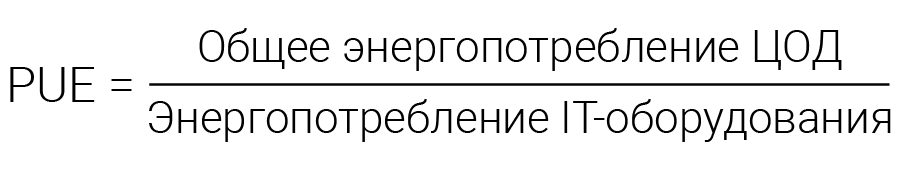

PUE — это показатель оценки энергоэффективности дата-центра. Мера была утверждена членами консорциума The Green Grid в 2007 году. PUE отражает отношение электрической потребляемой энергии к энергии, которая расходуется оборудованием.

Например, если дата-центр получает из сети 10 МВт мощности, а все оборудование «держится» на 5 МВт, показатель PUE будет составлять 2. Если «разрыв» в показаниях снизится, а оборудование будет потреблять большую часть электроэнергии, коэффициент будет стремиться к идеальному показателю — единице. На практике превосходными считаются значения PUE в районе 1,10-1,15.

Как показатель PUE ввели не из-за стремления сделать мир экологичнее. Важную роль сыграл финансовый фактор, когда в начале XXI века электричество стало стремительно дорожать. Поэтому провайдеры начали работать над оптимизацией энергопотребления.

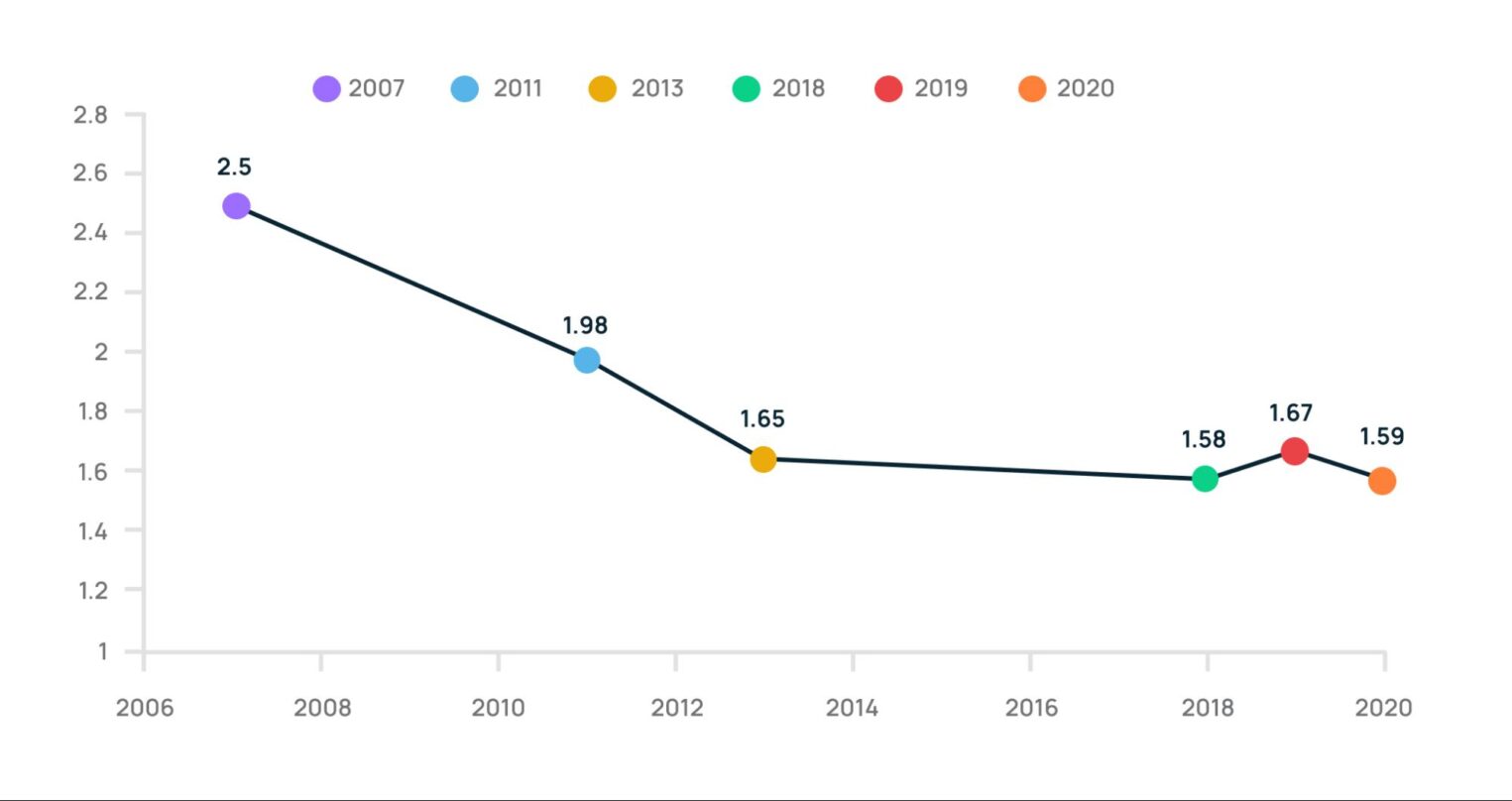

В 2020 году компания Uptime Institute презентовала доклад Global Data Center Survey. К тому времени средний мировой показатель PUE был оценен в 1,59 по выборке на базе 900 провайдеров.

На графике ниже показано, как менялось среднее значение PUE с 2006 года. Как видим, это число слишком отличается от превосходных значений параметра:

Способы снизить PUE

Энергоэффективность — это опыт, который приходит со временем. Поэтому в качестве рекомендаций рассмотрим именно то, что мы успели применить в своих дата-центрах.

Расширение температурных диапазонов

Оборудование раньше работало только в определенном узком температурном диапазоне, при поддержании которого отводится много тепла, что требует много электроэнергии. Один из вариантов решения задачи — увеличить температурный диапазон работы оборудования и отдавать наружу меньше тепла.

Так сделали и мы в свое время: ранее допустимым считалось значение в районе 18–20°C, но теперь мы допускаем, что температура может достигать 22–24°C. Это нормально, современное серверное оборудование и СХД надежно работает до 27°C. Более того, сегодня есть устройства, которые могут корректно работать при температуре воздуха до 40°C. Результат: можно меньше корректировать температуру в дата-центре и чаще использовать температуру внешней среды. Таким образом, для поддержания определенных условий в серверных требуется меньше электричества.

У нас информация о температуре в коридорах поступает круглосуточно дежурному системному инженеру с интервалом обновления в 30 секунд.

Если температура выходит за допустимые границы, раздается аварийный сигнал. Во время обходов инженеры измеряют температуру оборудования бесконтактными лазерными термометрами. Если мы обнаруживаем, что клиентское оборудование перегревается, — сразу же сообщаем об этом клиенту, указывая зафиксированную температуру.

Чиллеры вместо фреоновых кондиционеров

Показатель PUE классических фреоновых кондиционеров по современным меркам довольно высок и составляет 1,6–1,7, в то время как PUE чиллеров — в районе 1,4. То есть второй вариант более энергоэффективен.

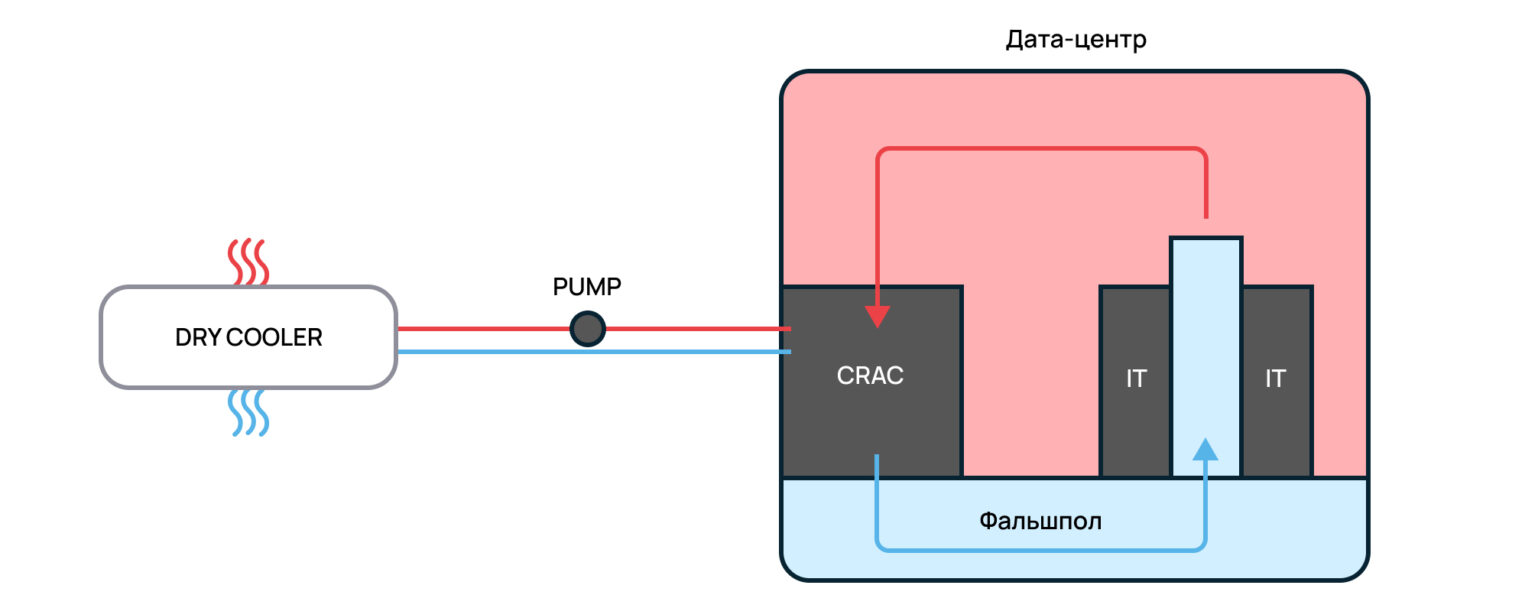

Чиллеры мы в Selectel опробовали в 2010 году, когда построили дата-центр «Дубровка 1». Отличие чиллерной системы от классических фреоновых кондиционеров в том, что в трубопроводах между внутренними и внешними блоками циркулирует незамерзающий гликолевый раствор, который остается все время жидким и не переходит в газообразное состояние.

Раствор прогоняется насосом через кондиционер в серверном зале, где нагревается от горячего радиатора кондиционера (в кондиционере может дополнительно стоять компрессорный блок), и откуда выкачивается в выносимый наружный теплообменник (чиллер). В нем он охлаждается с помощью наружного воздуха и дополнительного компрессорно-конденсаторного блока. Затем уже охлажденный гликолевый раствор вновь подается в кондиционер внутри серверного помещения дата-центра.

Энергоэффективность чиллерной схемы повышается за счет того, что внешний компрессорно-конденсаторный блок чиллера включается в работу лишь при температуре выше 12°C, причем вентиляторы внешнего блока запускаются постепенно, по мере роста температуры гликолевого теплоносителя. Это похоже на то, как работает система охлаждения обычного автомобильного двигателя.

Фрикулинг и АБХМ

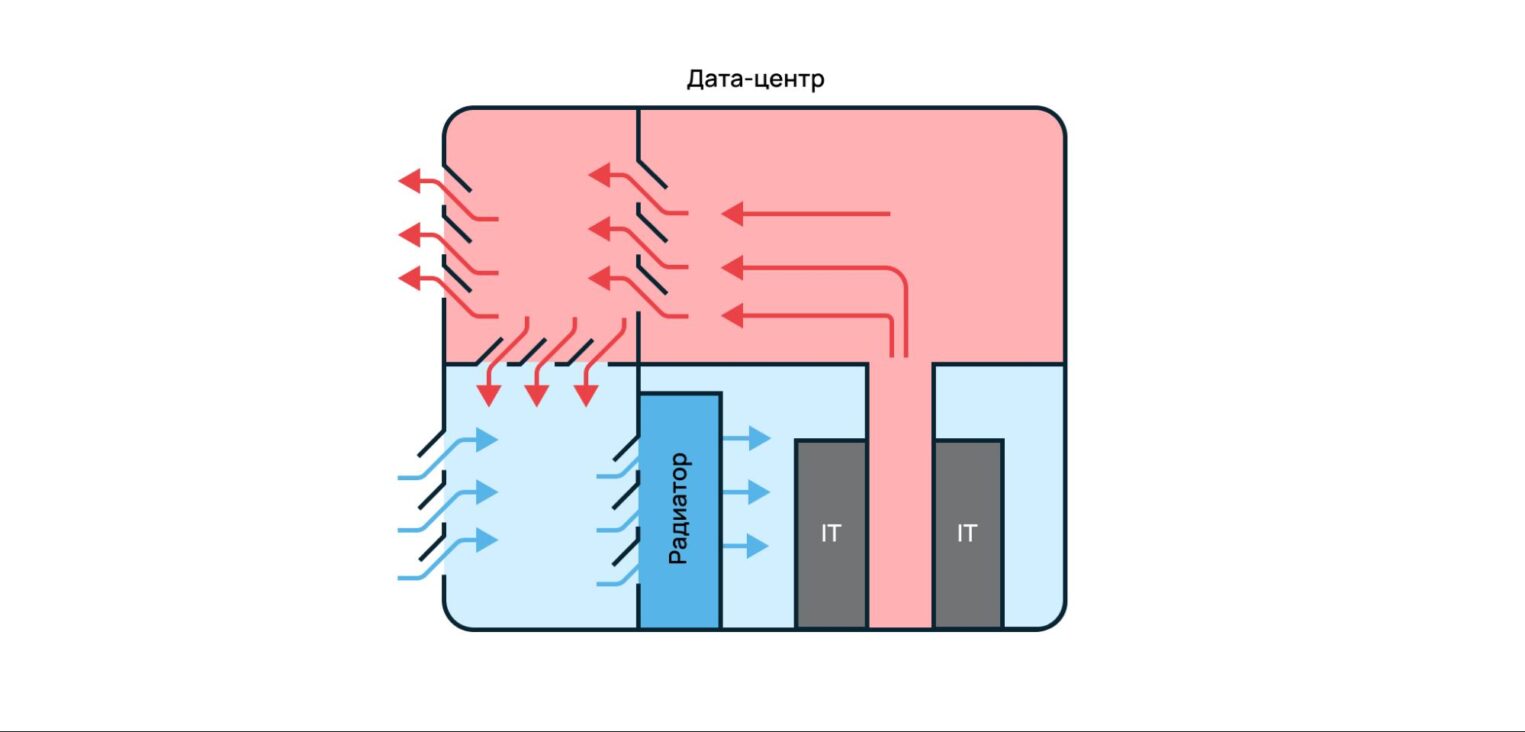

Следующий шаг в повышении энергоэффективности систем охлаждения мы сделали при переходе к схеме прямого фрикулинга с дополнительным охлаждением. Он заключается в отказе от теплообменников, где горячий воздух из дата-центра охлаждается. В схеме фрикулинга охлаждение серверов и сетевого оборудования происходит за счет обдува с помощью забортного воздуха, проходящего через наполненные холодной водой радиаторы дополнительного охлаждения.

Забортный воздух проходит через фильтры, где очищается от пыли, и далее поступает в машинный зал. В зимнее время холодный воздух предварительно «разбавляется» теплым в камере смешения. Так поддерживается постоянная температура обдува.

Как говорилось ранее, современное оборудование способно стабильно работать при 27°C. Однако температура воздуха в Ленинградской области и Москве, как показывает практика, может достигать 32°C.

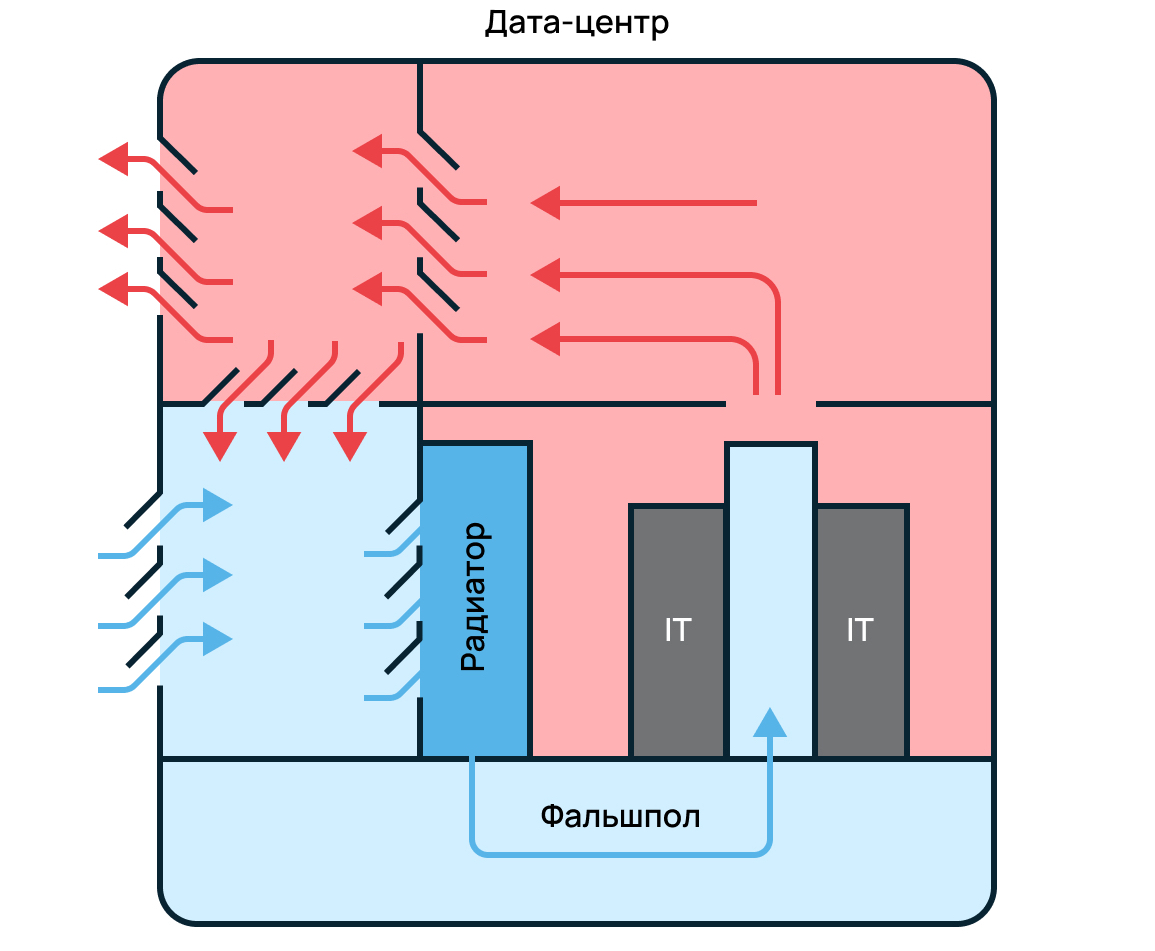

Поэтому в том же дата-центре «Дубровка 3», введенном в эксплуатацию в 2013 году, мы используем прямой фрикулинг с блоком дополнительного охлаждения — абсорбционную холодильную машину (АБХМ) — на случай летней жары. Забортный воздух проходит через фильтры теплообменника АБХМ. В холодные коридоры серверного зала воздух подается под фальшполом.

АБХМ включается в работу только летом, когда температура воздуха достигает 21°C. Это энергоэффективное решение, которое позволило достичь PUE ~1,25. Кроме того, АБХМ — экологически безопасная установка, потому что работает на воде без использования фреона.

Также система вентиляции поддерживает разность давлений между дата-центром и внешней средой. Из-за этого пыль в воздухе практически отсутствует: даже если она попадает в серверное помещение, ее сразу же выталкивает наружу.

Расходы на техническое обслуживание такой системы выше, чем в случае обычного охлаждения. Однако использование системы с АБХМ позволяет экономить за счет снижения расхода электричества на нагрев воздуха и его доохлаждение. В качестве источника энергии система использует природный газ, который подведен к ней трубопроводом. А резервное питание котлов АБХМ — на дизеле.

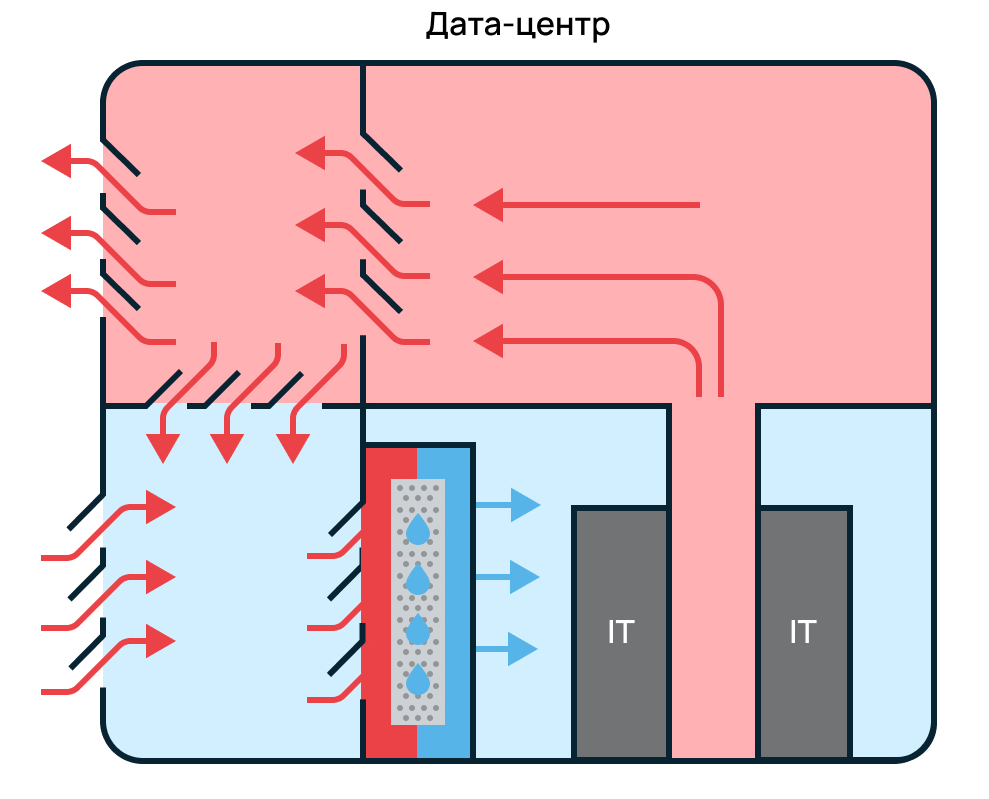

Фрикулинг и адиабатическая система доохлаждения

Система фрикулинг-АБХМ показала себя хорошо, поэтому в 2018 году система фрикулинга с дополнительным охлаждением была введена в дата-центре «Берзарина 2» в Москве. Из-за ограниченности пространства и эксплуатационных сложностей блок дополнительного охлаждения был реализован с помощью адиабатической системы.

Адиабатическая система охлаждения, как и АБХМ, запускается летом, когда воздух становится слишком теплым. Воздух предварительно охлаждается, проходя через фильтры с жидкостью.

Другие практики энергоэффективности

Мы уже поняли, что экологичность дата-центра связана не только с выбросами теплоты, но и потреблением электроэнергии как таковой. Поэтому рассмотрим практики по ее сокращению.

Мониторинг энергоснабжения

Повысить энергоэффективность также поможет банальное правильное использование мощностей, которыми располагает дата-центр. В наших дата-центрах серверы сами снижают электропотребление при отсутствии нагрузки и настройках «по умолчанию». При использовании специфических настроек управления питанием для энергоэффективности важно, чтобы они были корректными.

Ведь даже сервер минимальной конфигурации будет потреблять от 100 Вт, а более мощная инсталляция — в районе 600. Для отслеживания эффективности необходимо организовать мониторинг, чтобы следить за элементами инфраструктуры и нагрузками.

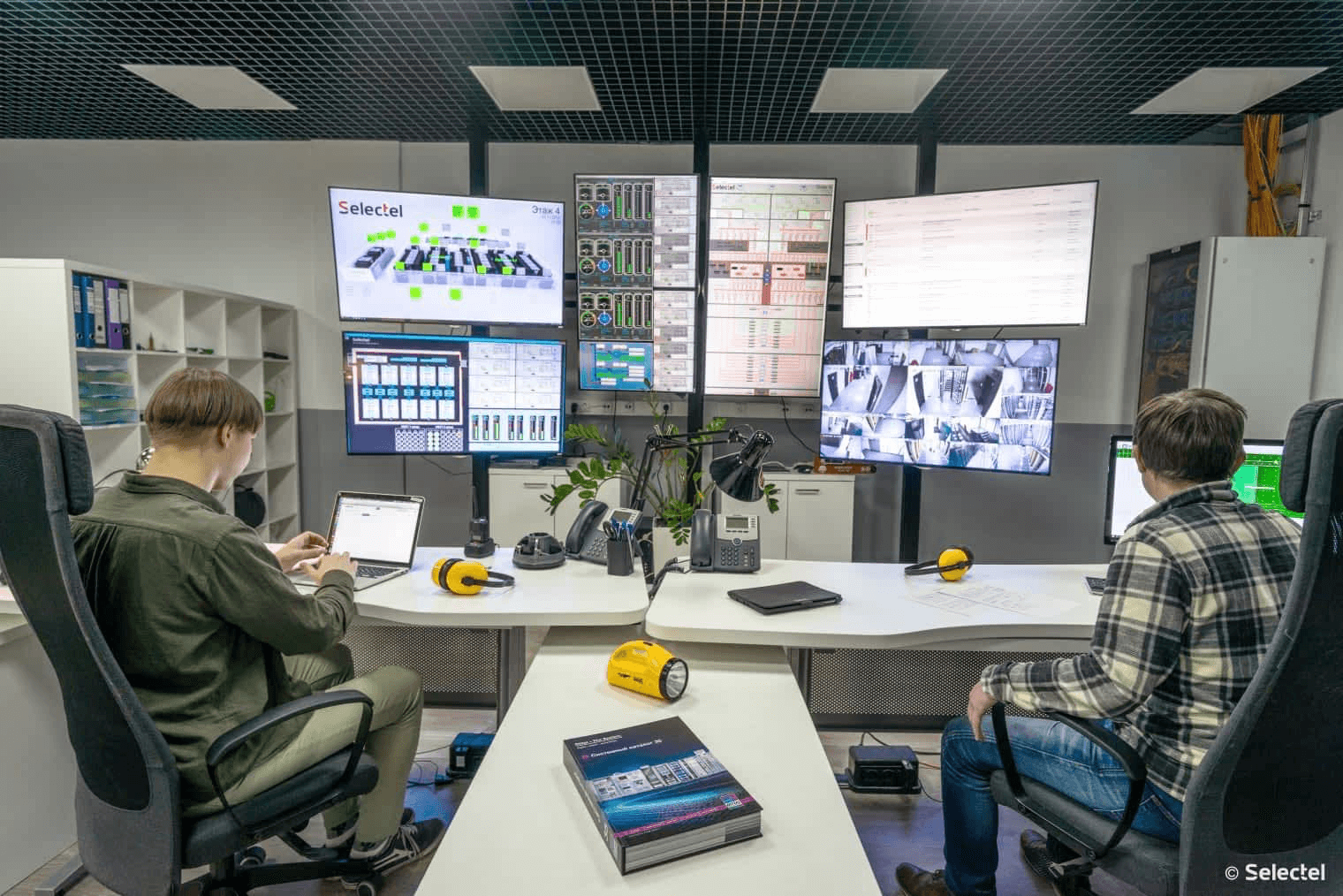

В Selectel для мониторинга мы используем специальные DCIM-системы. Но более важны в этом процессе люди — специалисты инженерно-технического отдела. Они работают в несколько смен и занимаются задачами отслеживания параметров электропитания и вентиляции в удаленном режиме.

Динамические ИБП вместо статических

Бесперебойная подача электропитания в серверные — обязанность дата-центра перед клиентами. Но важна не только отказоустойчивость решения, но и его эффективность с позиции потребления ресурсов.

Классические статические ИБП (с аккумуляторами) при отключении электроэнергии обеспечивают оборудование электропитанием в течение 5–30 минут. Этого времени хватает с запасом для переключения на дизель-генераторные установки (ДГУ).

Статические ИБП надежно резервируют питание критической нагрузки, но имеют ряд недостатков в сравнении с динамическими. Главные недостатки — это занимаемое место, узкий температурный диапазон работы, необходимость замены и утилизации аккумуляторов.

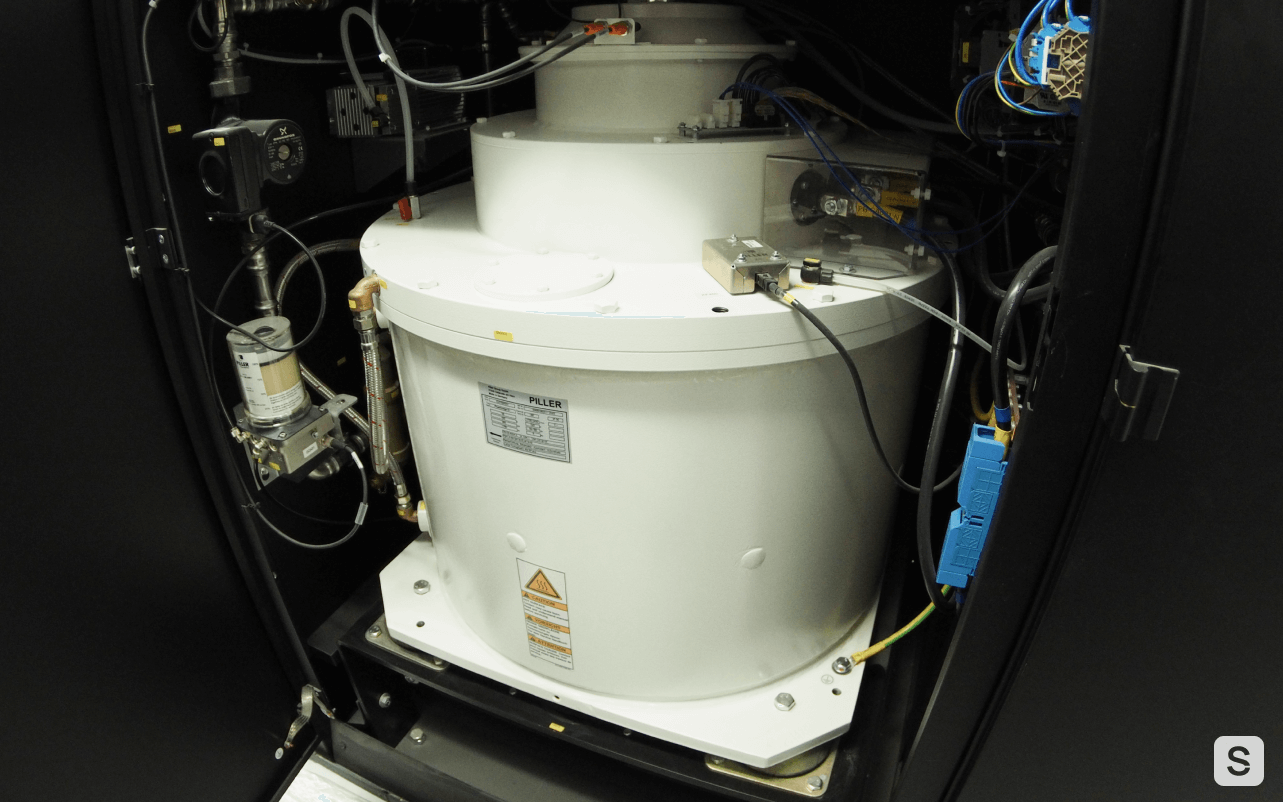

Принцип работы динамических ИБП заключается в накоплении кинетической энергии вращающегося маховика. В момент отключения электропитания, за счет инерции вращения маховика они генерируют электроэнергию. Главный минус динамических ИБП — ограниченное время резервирования: они могут поддержать работу оборудования в течение всего 30 секунд при полной нагрузке. Но и этого достаточно для подключения ДГУ.

Также из-за отсутствия аккумуляторных батарей в динамических ИБП провайдеру не нужно закладывать место для их размещения. Свободную площадь можно использовать, например, для размещения серверных стоек.

В общем, динамические ИБП куда рациональнее и экологичнее статических предков, поэтому мы перешли на них. Сегодня в дата-центрах Selectel используются установки Piller CPM300 — о них подробнее рассказали в отдельной статье.

«Умное освещение»

Общее электропотребление дата-центра можно снизить, заменив системы освещения. Так мы в начали использовать датчики присутствия. Они работают по простому принципу: свет включается только тогда, когда в серверной комнате появляется человек. В остальное время работает только аварийное освещение.

Почему дата-центры нужны не только бизнесу

Не только серверное оборудование потребляет электроэнергию во время вычислений, но и персональные компьютеры. Ранее распространенный процессор Core i7-6700 потреблял около 100 Вт электричества — сегодня это сравнительно мало. Новые модели чипов требуют от 250 Вт энергии, а некоторые — до 400.

Электропотребление ПК усиливается тем, что сегодня люди приобретают мощное железо, иногда опережающее по характеристикам серверы в дата-центрах. Причин здесь много — от майнинга биткоина до попытки запустить портированный ремейк The Last Of Us в 60 fps. Но есть проблема: не каждый владелец ПК заботится об энергоэффективности своего устройства, которое может потреблять несколько кВт*ч в день.

Это значит, что в перспективе может быть выгоднее, энергоэффективнее и экологичнее использовать виртуальные ресурсы облачного провайдера. Виртуализация дает возможность перераспределять и наращивать процессорные мощности, ОЗУ и объем памяти по мере необходимости. Поэтому электроэнергия тратится только на обеспечение работы, исключая затраты на простаивающее оборудование.

Результат: капитальные затраты пользователей переходят в операционные, электроэнергия потребляется рациональнее, провайдер заботится об утилизации ресурсов и выбросов, а мир становится зеленее.

Еще один способ сделать мир зеленее

Невозможно добиться абсолютной энергоэффективности. Например, текущий PUE для дата-центра «Дубровка 3» составляет 1,25, а для «Берзарина 1.4» — 1,15–1,2.

Мы следим за значением коэффициента и стремимся использовать более энергоэффективные решения по охлаждению, освещению и другим аспектам работы.

Кроме того, мы активно сдаем на утилизацию аккумуляторные батареи, этиленгликоль из систем охлаждения и даже макулатуру. Все, что можно починить, — чиним, а устаревшую технику перепродаем сотрудникам, если есть такой запрос.

Чтобы компенсировать влияние на природу, которое косвенно оказывают дата-центры, потребляя электроэнергию, Selectel уже четвертый год высаживает деревья в Московской и Ленинградской областях. Так мы стремимся внести вклад в развитие регионов, где находятся наши собственные дата-центры. В рамках акции «Зеленый Selectel» мы уже высадили 80 000 деревьев. Будущий лес сможет ежегодно перерабатывать до 1,76 млн кг CO2.

Как проходят посадки деревьев, смотрите в видео: