Современное серверное оборудование сильно зависит от температурного режима, в котором оно работает. Перегрев процессоров ведет, в лучшем случае, к замедлению работы (вступает в действие механизм защиты, так называемый «троттлинг»). В худшем случае, перегрев способен полностью вывести процессоры из строя.

Чрезмерное охлаждение оборудования также не идет ему на пользу. Любой материал имеет определенный коэффициент теплового расширения, и низкие температуры негативно влияют на чувствительные элементы оборудования.

Для того чтобы наглядно увидеть распределение тепла и холода, а также измерить скорость воздушных потоков, мы используем два специфических инструмента, о которых сейчас детально расскажем.

Используемые инструменты

Тепловизор

Из курса физики мы помним, что если любое тело имеет температуру выше −273,15 °C (абсолютный ноль), то оно излучает электромагнитное тепловое излучение. Это излучение и фиксирует тепловизор, превращая его в цветную картинку распределения температуры. Каждый цвет обозначает определенную температуру. Наиболее часто используемая гамма в тепловизорах – это красно-синий градиент. Красный цвет означает высокую температуру, а синий цвет – низкую.

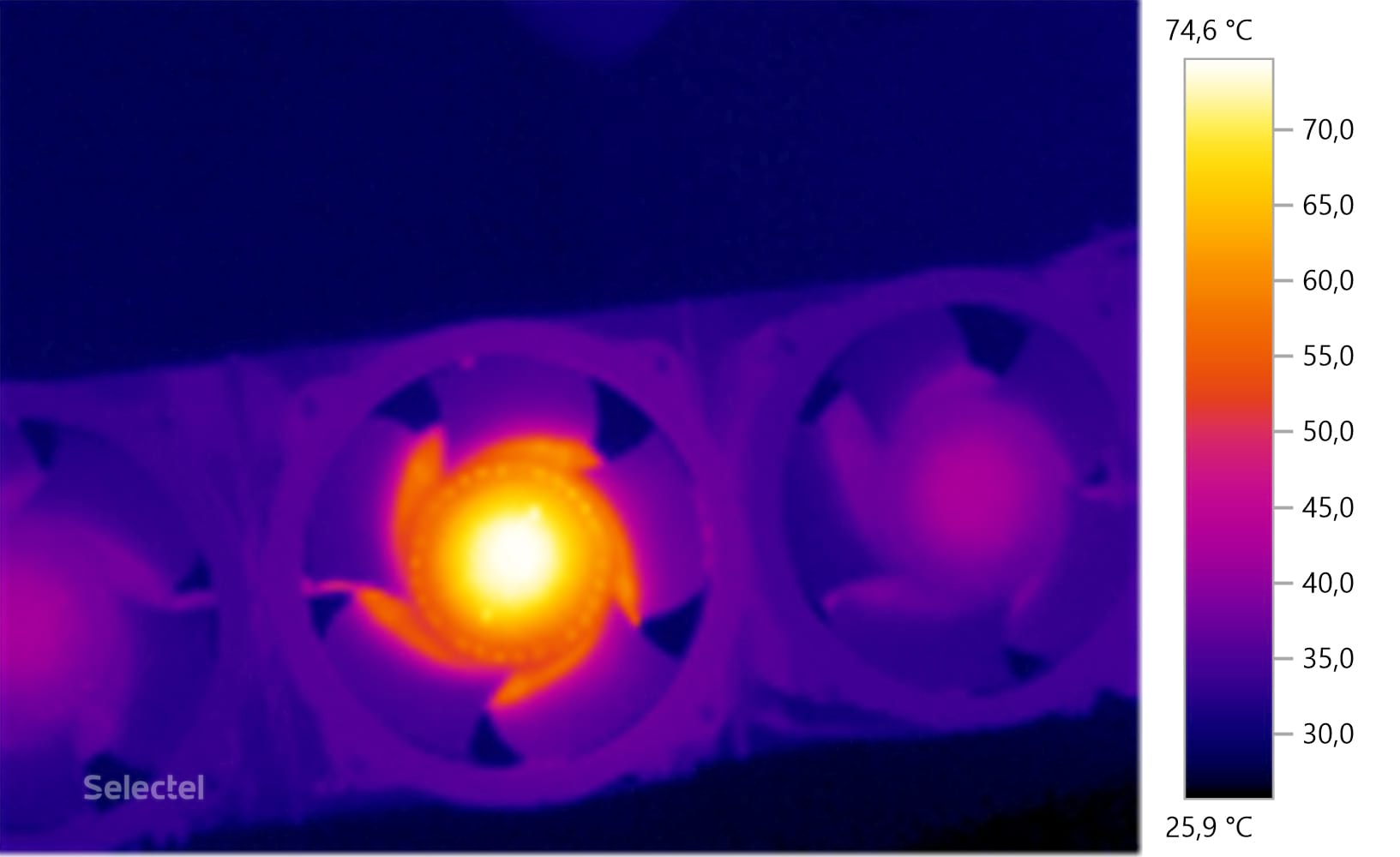

Современные тепловизоры, используемые в наших дата-центрах, позволяют не просто измерить диапазон температур, в котором работает оборудование, но и узнать температуру заданной точки объекта с точностью до десятых долей градуса.

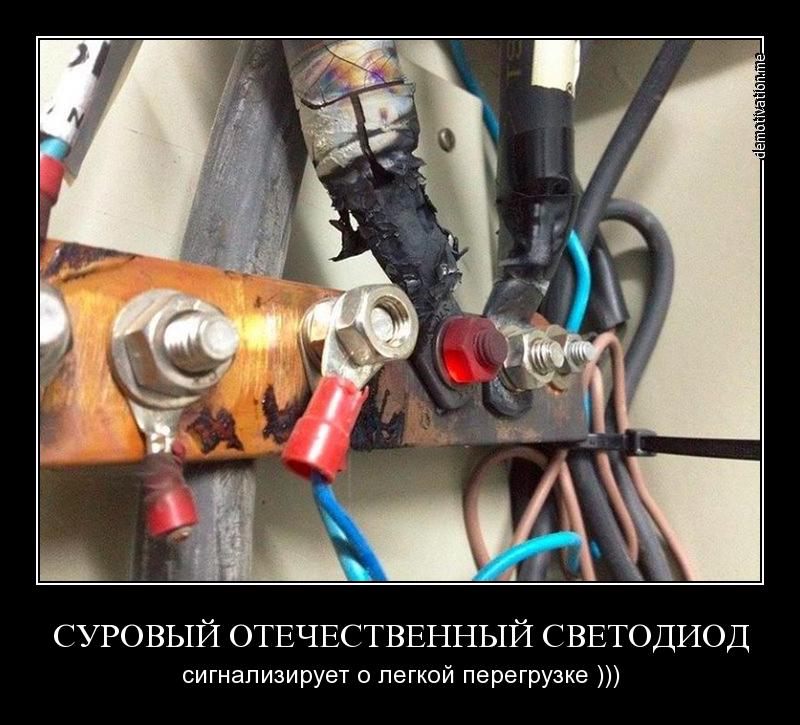

Одной из основных задач применения тепловизора в дата-центре является контроль за температурой на электроустановках под напряжением. Сразу вспоминается известный демотиватор:

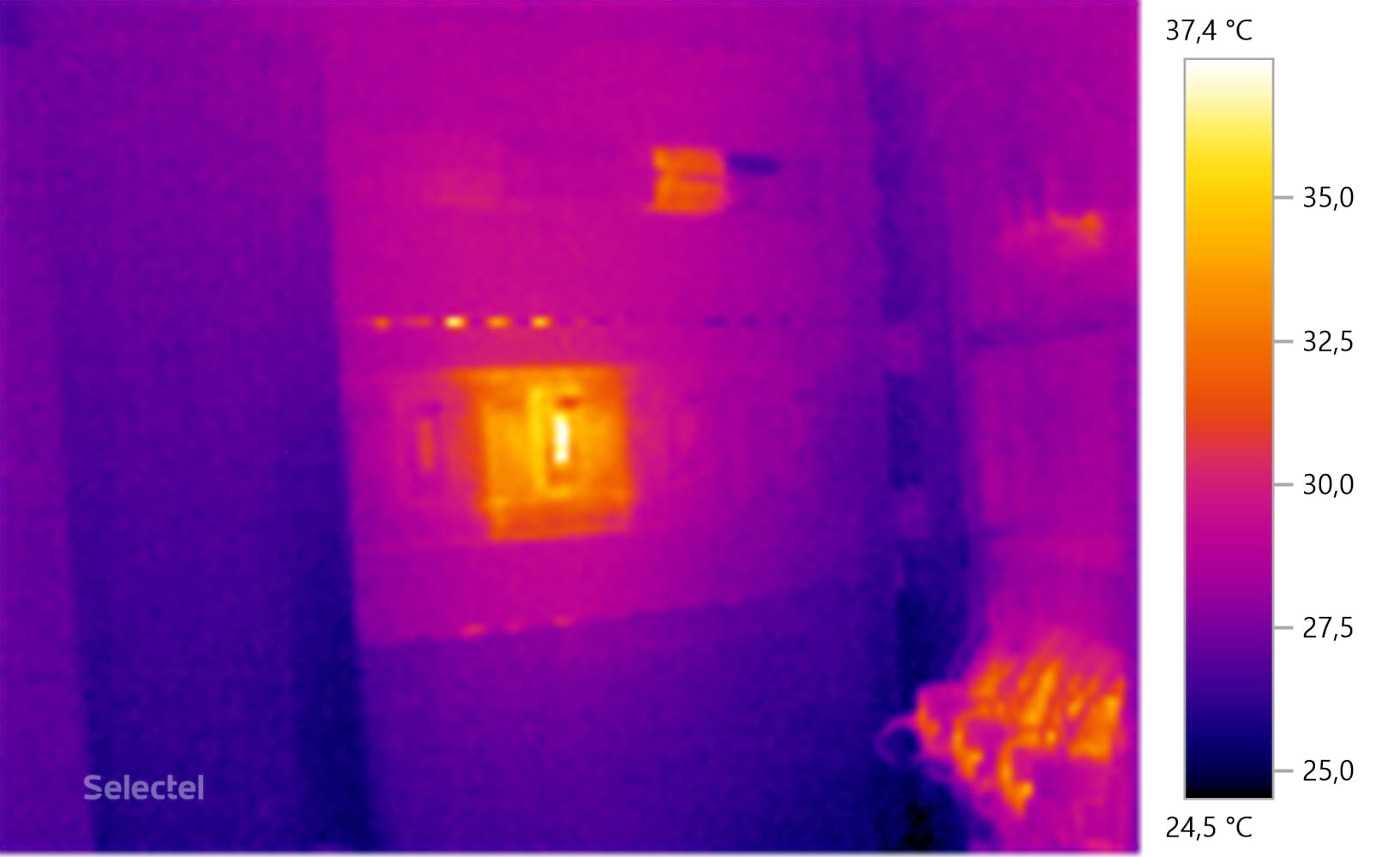

В реальных условиях подобные ситуации недопустимы. С помощью тепловизора можно легко выявить элементы электроустановок, которые начинают аномально нагреваться. Например, можно выявить вентилятор источника бесперебойного питания, который скоро выйдет из строя и будет нуждаться в срочной замене.

Вот небольшой пример обнаружения проблемного участка в щите автоматов. Все работает, однако виден аномальный нагрев блока автоматов сверху и вводного автомата посередине.

Использование тепловизора позволяет выявить проблему еще на этапе возникновения, что снижает риск ее негативного воздействия на инфраструктуру, поэтому данный прибор незаменим для использования в дата-центре.

Анемометр

Теперь кратко расскажем о таком приборе, как анемометр. Это устройство для измерения скорости воздушного потока. Наиболее часто эти приборы используются в метеорологии для измерения скорости ветра, а также в строительстве для расчета объема воздуха в системах вентиляции и кондиционирования.

В дата-центрах чаще всего используются анемометры с крыльчатым зондом, поскольку они мобильны и удобны для использования. Зонд представляет собой легкую крыльчатку, которая начинает вращаться даже при самом легком движении воздуха. Выглядит такой прибор следующим образом.

Для чего нужен анемометр в дата-центре? В основном для контроля скорости воздушных потоков, создаваемых системами кондиционирования воздуха. Для эффективного охлаждения воздуха в серверных помещениях существуют заранее рассчитанные значения скорости, которые необходимо поддерживать. Именно эту задачу решают с помощью анемометра.

В наших дата-центрах используются анемометры с зондами и датчиками, которые прошли контрольную поверку, что позволяет точно оценивать такие параметры как измерение интенсивности воздушных потоков, а также измерять температуру и влажность воздуха.

Предположим, что обследование серверного помещения выявило недостаточную подачу холодного воздуха. С помощью анемометра можно выполнить контрольный замер воздушного потока и исправить проблему до того момента, как она начнет затрагивать оборудование.

Что происходит внутри сервера

Поговорим немного о том, почему так важно соблюдать температурный режим для серверного оборудования. Оговоримся сразу – это информация для людей, которые слабо себе представляют процессы, происходящие внутри такого оборудования.

Начнём с того, что любой сервер – это обычный мощный компьютер, но имеющий множество серьезных отличий:

- все компоненты рассчитаны на круглосуточную работу в режиме 24/7/365;

- охлаждение реализовано таким образом, чтобы сквозь корпус проходило максимальное количество воздуха;

- радиаторы процессоров используются чаще всего пассивные, то есть без размещения на них отдельных вентиляторов;

- корпус спроектирован таким образом, чтобы можно было быстро заменить любой компонент.

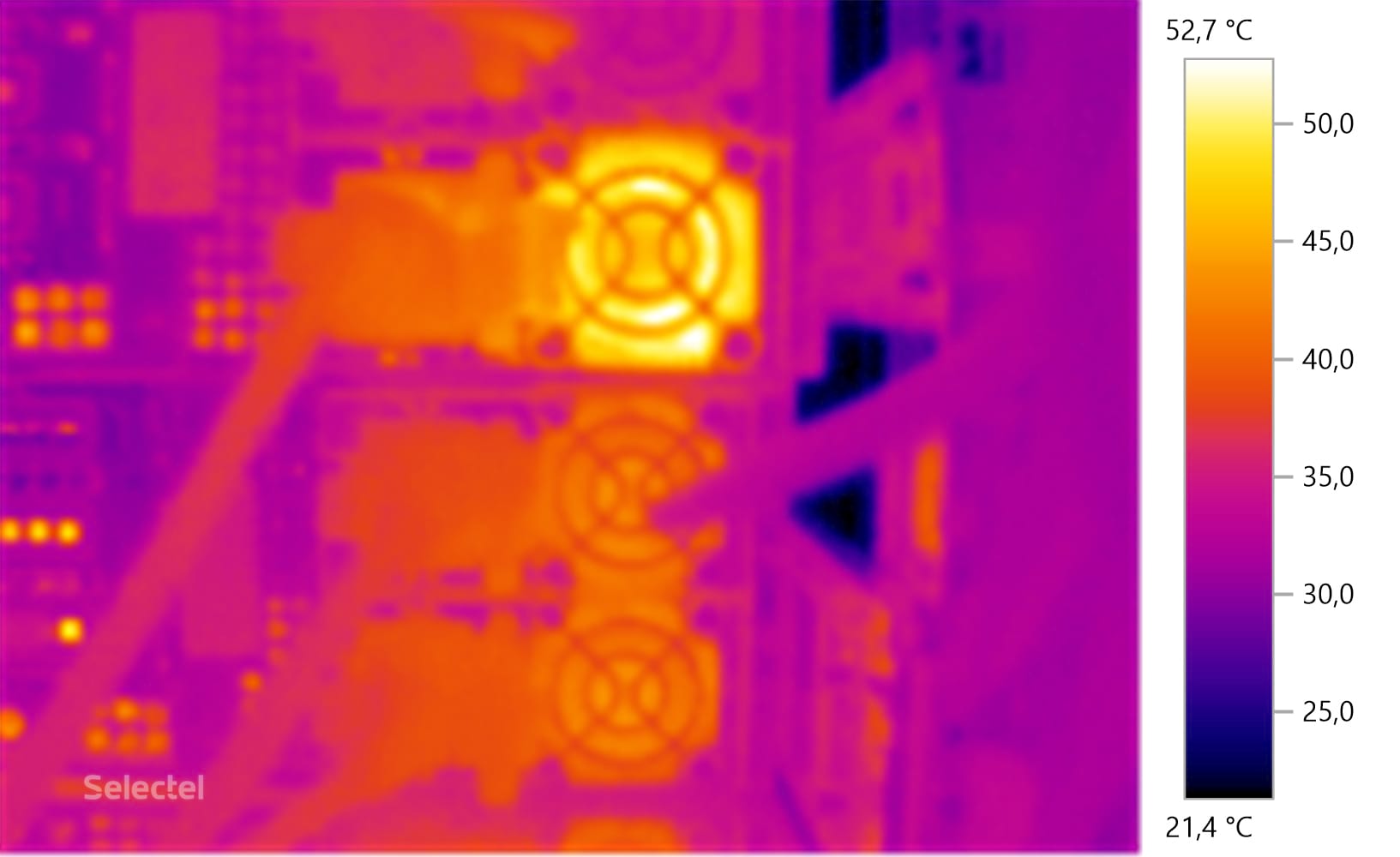

Современные серверы выделяют огромное количество тепла в процессе работы, но при этом для каждого компонента есть свои требования к температуре. Штатная система охлаждения таких серверов изначально проектируется на эксплуатацию в дата-центрах. Давайте посмотрим, как это выглядит изнутри.

Нагрев процессоров

Центральным элементом любого сервера является центральный процессор. Кремниевый кристалл с миллиардами крошечных транзисторов в процессе работы сильно нагревается. Стабильное охлаждение этого элемента в современных серверах обеспечивают пассивные радиаторы, сквозь которые проходит мощный поток воздуха.

Нагрев дисков

Вне зависимости от типа дисков, будь то твердотельные накопители или же классические жесткие диски, все они в большом количестве выделяют тепло. В первом случае греются чипы памяти, а во втором случае – диск разогревается двигателем шпинделя.

Нагрев оперативной памяти

Также, как и в случае с SSD-дисками, нагреваются чипы памяти. Некоторые виды оперативной памяти специально снабжаются штатными пассивными радиаторами для отвода избыточного тепла. Если доведется вскрывать такой сервер сразу после его выключения – рекомендуем быть осторожными. Температура радиаторов оперативной памяти легко может оставить ожог на пальцах.

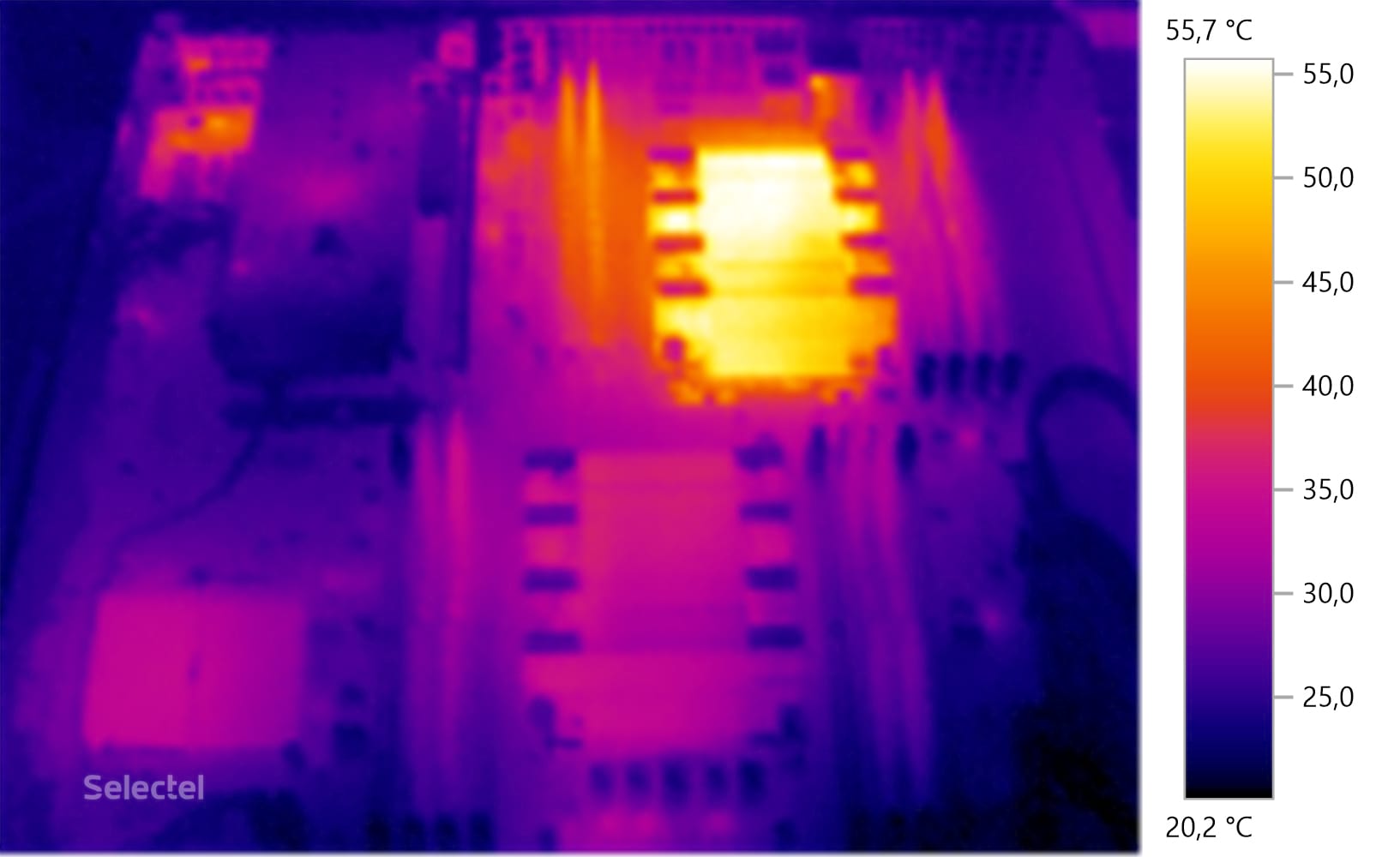

Нагрев блоков питания

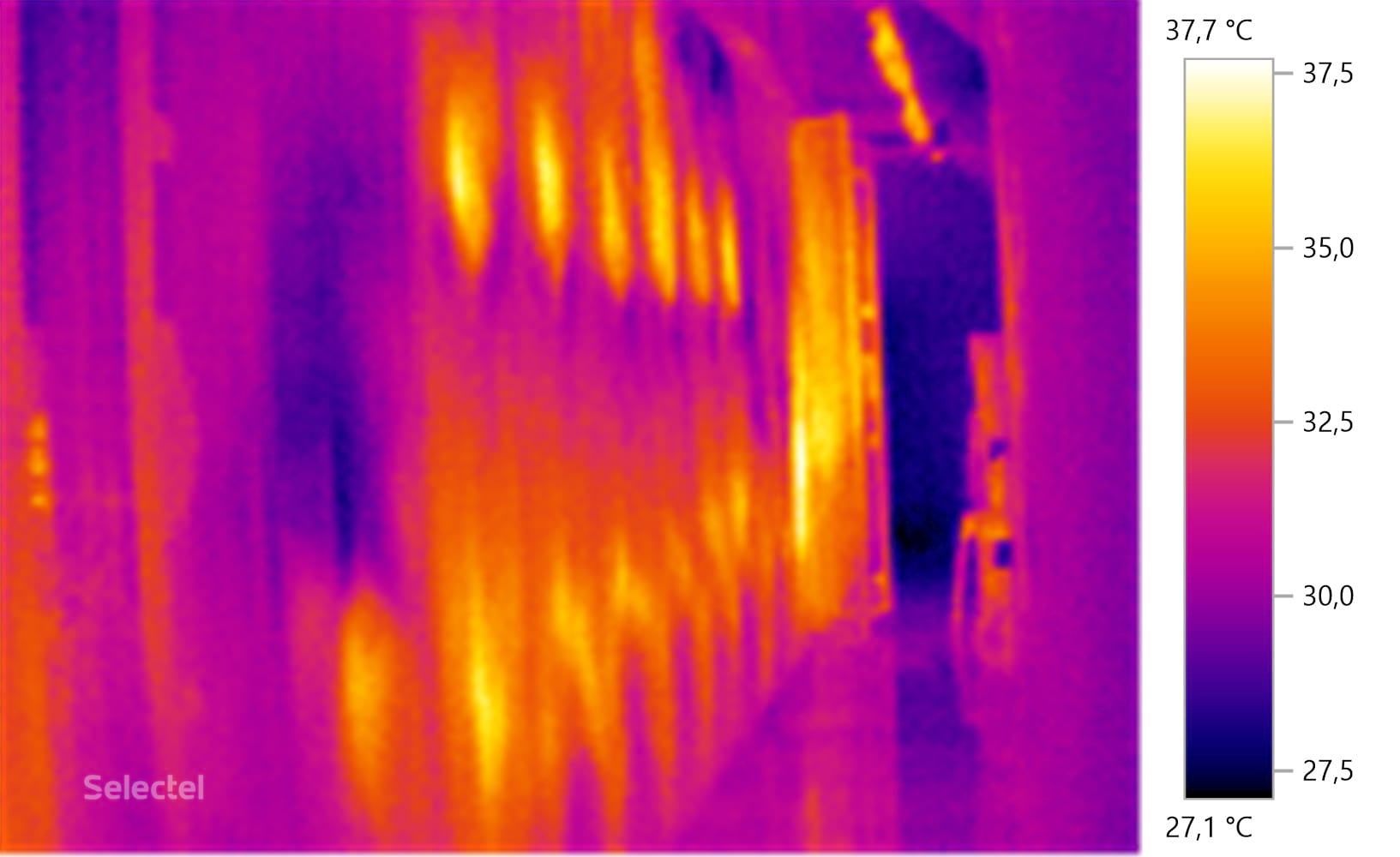

Задача любого блока питания – преобразовывать стандартные 220 вольт, 50 герц в постоянный ток различных напряжений для питания компонентов сервера. Побочным результатом таких преобразования является выделение тепла, что хорошо видно на следующем термоснимке.

Как видно на снимках, все компоненты нагреваются до значительных температур, поэтому предлагаем посмотреть каким образом дата-центры выводят это тепло и обеспечивают эффективное охлаждение оборудования.

Наши дата-центры используют схему циркуляции воздуха с формированием двух различных температурных зон:

- «холодный коридор», куда подается воздух из кондиционеров;

- «горячий коридор», куда попадает уже нагретый оборудованием воздух.

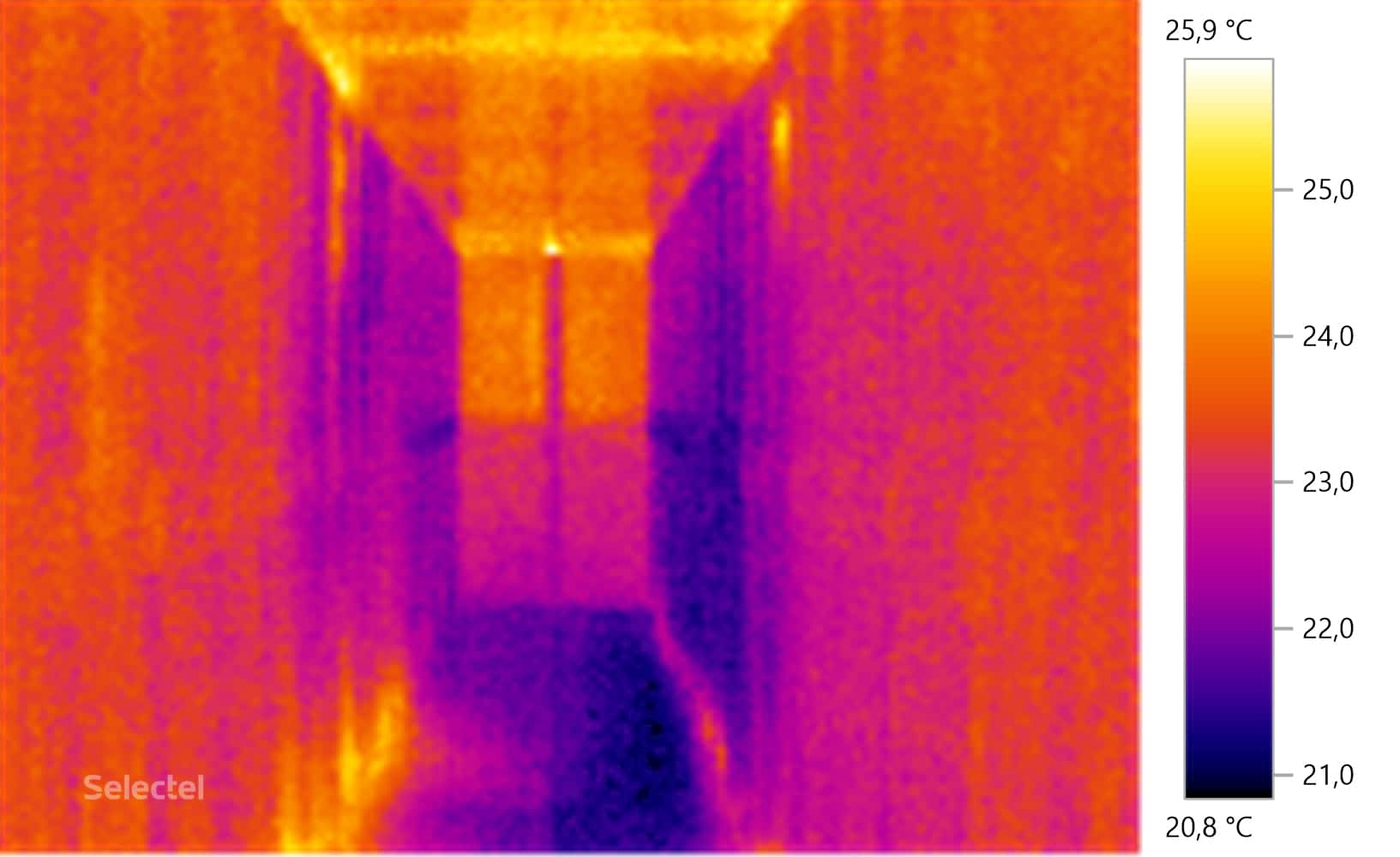

Вот как это выглядит, если посмотреть на эти зоны тепловизором.

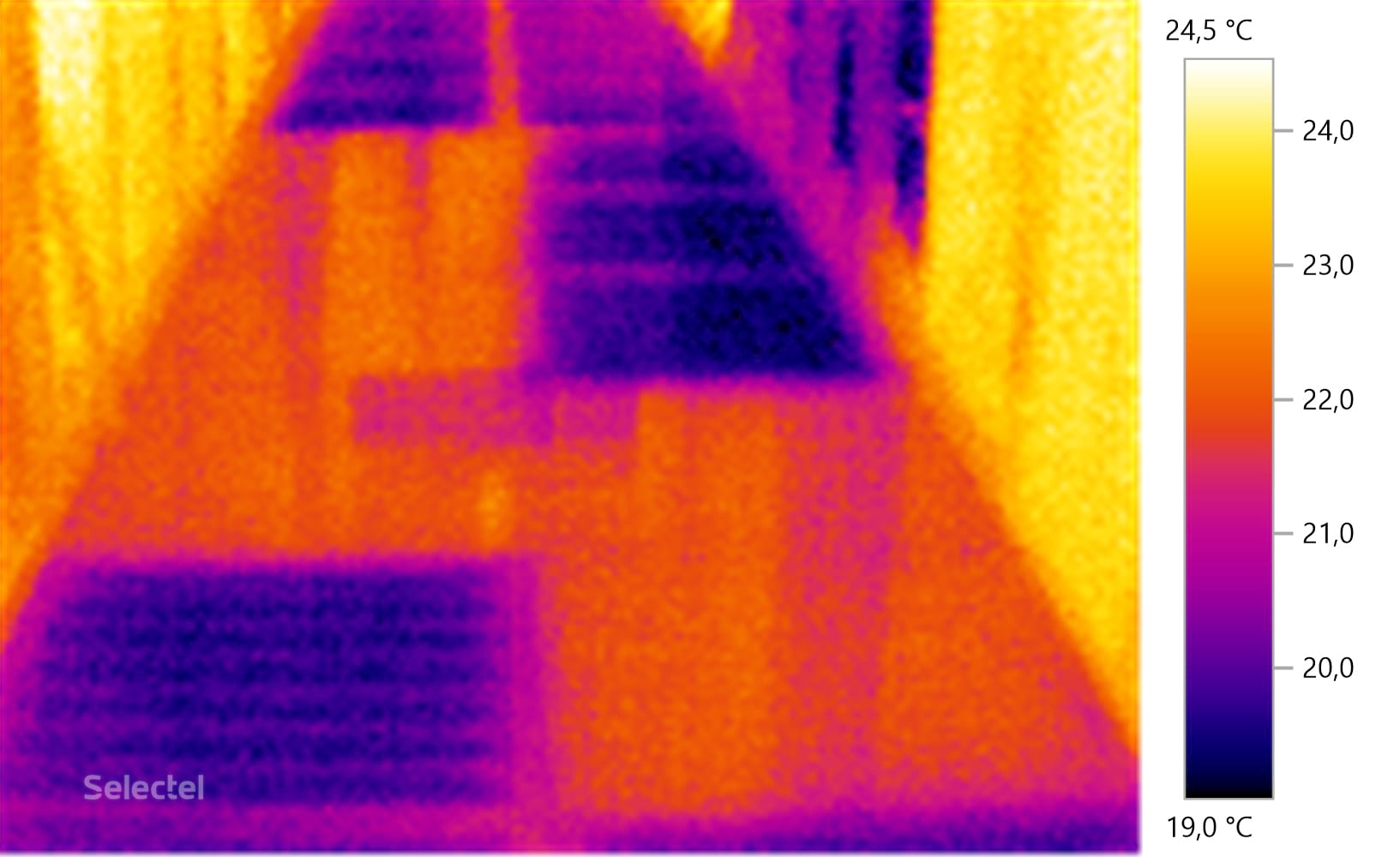

Как выглядит «холодный коридор» ЦОД

Для наглядности снимок с фальшполом. Там, где плитки закрыты – стойки еще не введены в эксплуатацию. Это сделано специально, впоследствии все плитки пола были заменены на перфорированные.

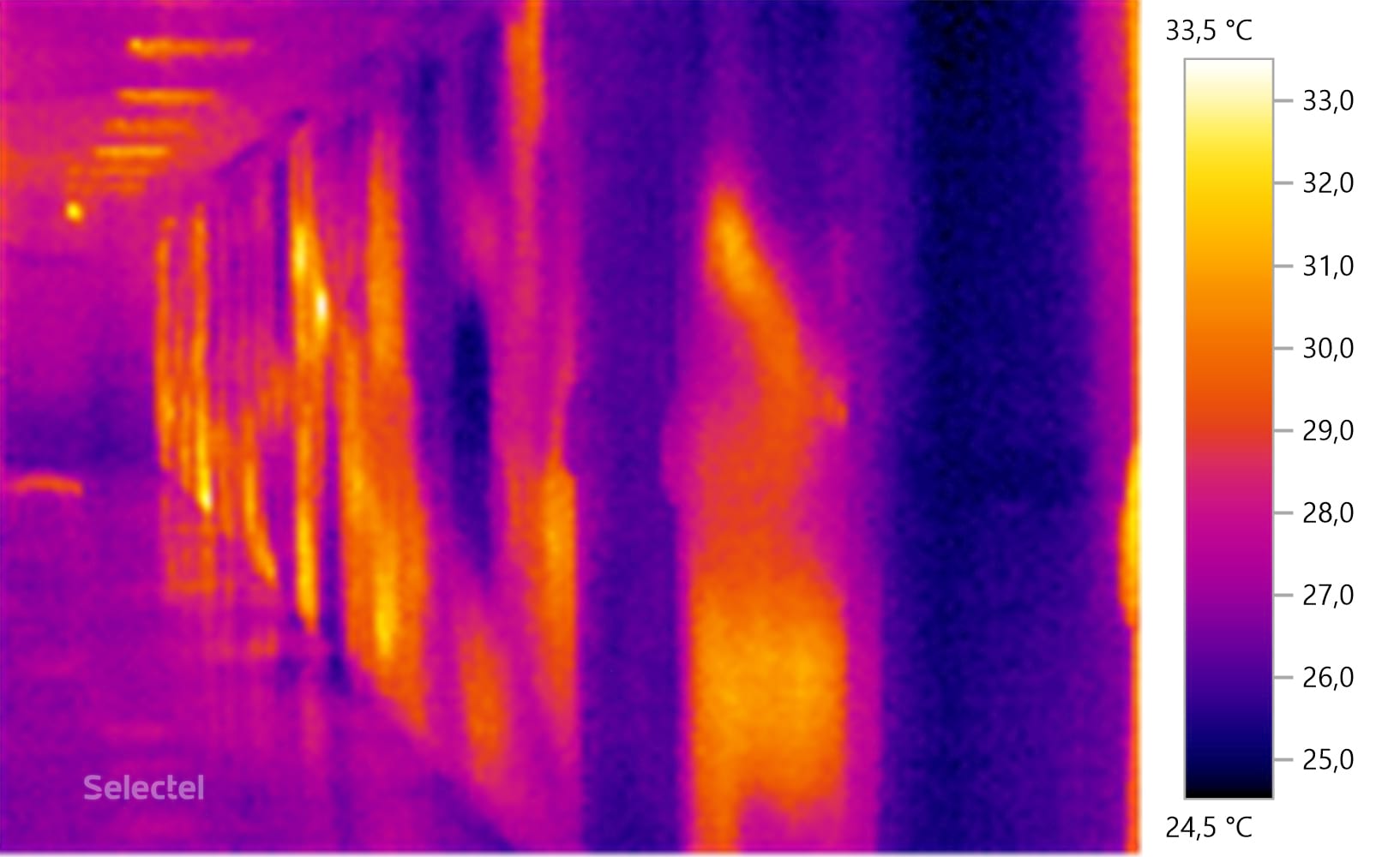

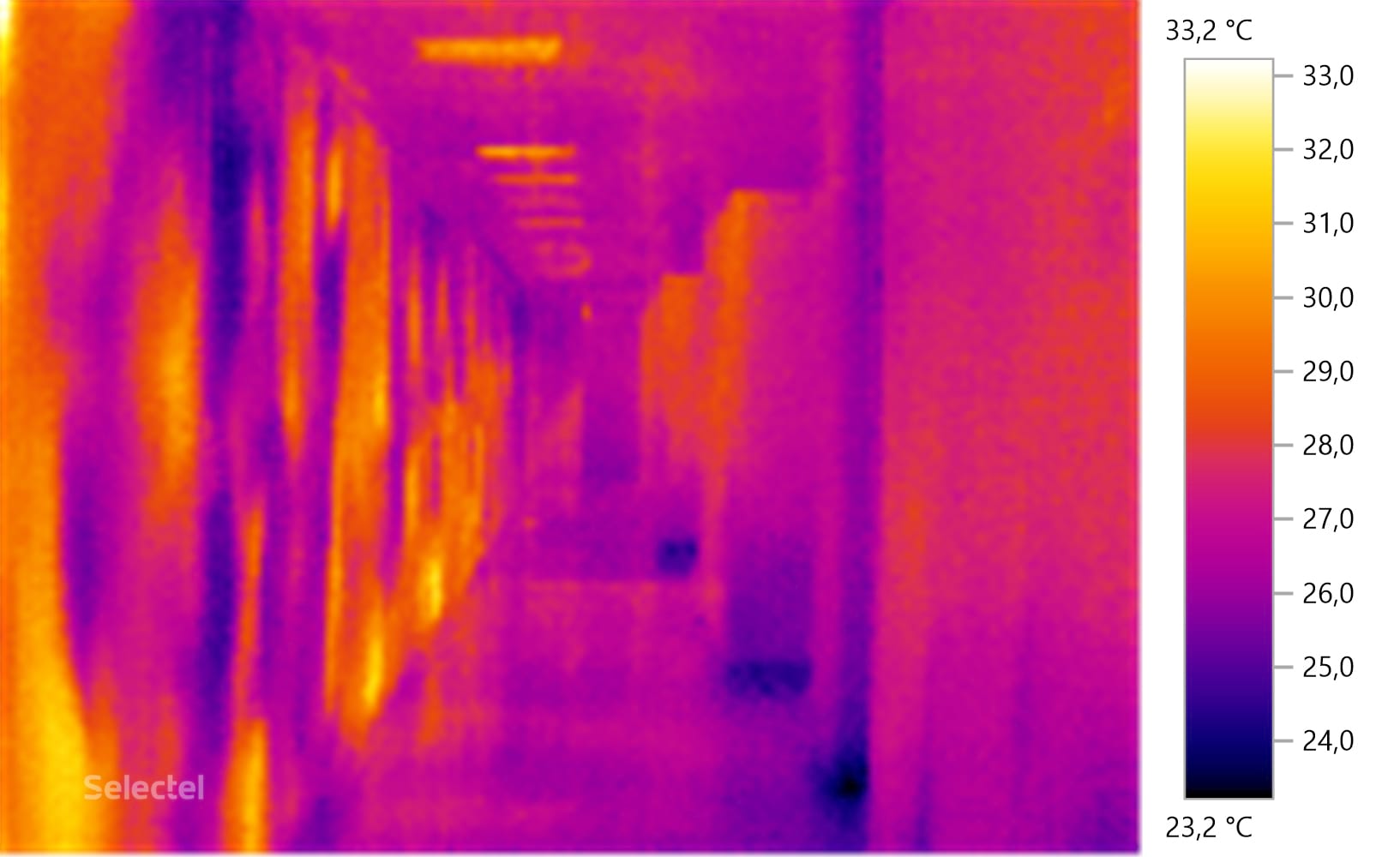

Как выглядит «горячий коридор» ЦОД

В наших дата-центрах размещается большое количество серверного оборудования, работающего под разной нагрузкой. Этим объясняются подобные границы тепловых зон.

С левой стороны расположены серверные стойки, а с правой стороны можно заметить прецизионные кондиционеры системы охлаждения, которые и забирают на себя все выделяющееся тепло. Воздушный поток проходит сквозь теплообменник с хладоносителем, отдавая тепло, после чего возвращается обратно в «холодный коридор». Теплоноситель (40% раствор этиленгликоля) поступает в холодильную машину (чиллер), охлаждается и возвращается для нового цикла работы.

Когда в стойках установлено много одинакового оборудования по однотипной схеме, то это выглядит достаточно интересно.

Заключение

Организация охлаждения серверного оборудования встает перед любой компанией, которая владеет даже небольшим серверным помещением. Решение этой задачи несет за собой большие капитальные затраты на построение системы охлаждения. Помимо этого, такие системы необходимо регулярно обслуживать, что также требует постоянных вложений.

В наших дата-центрах система кондиционирования организована на профессиональном уровне, поэтому не стоит «изобретать велосипед» – достаточно всего лишь разместить у нас оборудование и сосредоточиться на действительно важных вопросах функционирования сервисов. Поддержание комфортной температуры и бесперебойное электропитание – это уже наша забота.

Расскажите нам в комментариях – с какими интересными случаями в работе систем охлаждения вы сталкивались?