Привет! Меня зовут Василий, я инженер по диагностике оборудования в Selectel. Мы постоянно работаем над шерингом знаний в командах, чтобы ускорять процессы установки и замены оборудования. Сегодня хочу рассказать, как устроена миграция серверов в контуре провайдера, и что при этом чувствует клиент.

Миграция серверов необходима для утилизации мощностей, оптимизации охлаждения и упорядочивания конфигураций, поскольку мы стремимся размещать новые стойки рядом с парком, который уже арендован клиентом. Наша главная цель при переезде — повысить качество сервиса, минимизировать риски и даунтаймы. Положения о качестве предоставляемых услуг фиксируются в SLA, поэтому мы также делаем процессы прозрачнее для всех. В статье — история о том, как это работает.

Большое приключение для маленького сервера

Ключевая часть подготовки — планирование работ с прописанными сроками и проверками в каждой контрольной точке. Формулировка «переехать за месяц» абстрактна, поэтому дедлайны нужно выставить для каждого шага.

Процесс миграции можно разделить на пять основных блоков работ:

- планирование,

- логистика,

- подготовка стоек,

- оповещение,

- миграция.

Планирование

Определив цели миграции, мы разрабатываем роадмап:

- Изучаем место для размещения серверов, чтобы не создавать «лапшичные».

- Рассчитываем необходимое электропитание с запасом на случай масштабирования инфраструктуры.

- Проверяем мощности охлаждения. В дата-центрах Selectel используются системы фрикулинга, фреон, чиллеры, а также промышленные кондиционеры.

- Заказываем и резервируем оборудование, которое потребуется для подготовки стоек. В эту группу входят термостаты, устройства мониторинга состава атмосферы в машинном зале, индикаторы влажности, распределители питания.

Дата-центр уровня Tier III потребляет столько же электроэнергии, сколько город-миллионник. О том, как Selectel работает с энергоэффективностью, рассказывает Кирилл Малеванов, технический директор Selectel.

Чтобы выбрать стойки для размещения, нужно обратить внимание на следующие параметры:

- Мощность стойки по проекту. К стойкам подводится сразу два ввода электропитания через распределительные шкафы с автоматами. С резервированием в качестве ИБП с аккумуляторами и ДГУ. Если с одним блоком питания или PDU будут проблемы — на клиентской инфраструктуре это не отразится.

- Габариты стоек. Самые распространенные имеют глубину от 60 до 110 см и ширину 48,6 см. Высота стоек измеряется в юнитах (U), 1U= 4,445 см или 1,75 дюйма. В основном используются 47U стойки размером 19 и 21 дюйм (48,26 и 53,34 см).

- Наличие автоматического ввода резерва (АВР) — устройства балансировки питания в стойке, где используются серверы с одним БП.

Задачи АВР

- В стойках АВР переключает нагрузку с одного ввода на другой в случае возникновения проблем с одним из вводов.

- В источниках бесперебойного питания (ИБП) АВР переключает нагрузку с основного ввода на байпас.

- В главных распределительных щитах АВР переключает нагрузку между вводом от города и резервным питанием от дизель-генераторных установок.

Резервируем место

Поскольку работа по расширению количества доступного оборудования ведется постоянно, важно не спутать карты других отделов и зарезервировать стойки под необходимый проект. После согласуем сетевое оснащение будущих стоек, исходя из общих правил и тенденций:

- утилизации портов,

- только проверенные и протестированные вендоры,

- современное оборудование,

- наличие на горячем складе ЗИПа.

Обычно в ЗИПе находятся идентичные комплектующие, как в рабочей стойке, но всегда закладывается потенциал для апгрейда мощностей. Это помогает оптимизировать логистику и сэкономить время на модернизацию.

Для учета расходных материалов, быстрого проведения кроссировок и оптимального размещения мы даже написали собственное приложение.

Логистика

После этапа согласований мы приступаем к пополнению оборудования.

Наши дата-центры расположены в Санкт-Петербурге, Москве, Новосибирске и Ташкенте, а общее количество стоек превышает 3400 единиц. Поэтому процесс отлаженной логистики — важный аспект всех процессов компании. Мы постоянно актуализируем наличие оборудования на складах и производим перемещение в локацию, где необходимо пополнить резерв, либо развернуть крупный проект.

Клиентам, которые работают с зарубежными пользователями, мы предлагаем использовать Direct Connect для связности с гипероблаками. С такой организацией инфраструктуры, сервис может хранить персональные данные граждан локально, и соответствовать законодательству. Кроме этого, решение позволяет избегать блокировки IP-адресов.

Подготовка стоек

После доставки оборудования приступаем к монтажу:

- Подключаем электричество к стойке в соответствии со стандартами уровня Tier III (с резервированием N+1).

- Монтируем и настраиваем распределитель питания или Power Distribution Unit (PDU). Все наши PDU находятся на центральном мониторинге, который позволяет реагировать быстро, если возникнет экстренная ситуация. Это необходимая часть будущей стойки со стороны организации питания и информативности об алармах для дежурной смены.

- Устанавливаем сетевое оборудование. Подключаем аплинки, настраиваем и ставим оборудование для мониторинга.

- Занимаемся доработками: разносим структурно кабельную систему (СКС), подготавливаем кабели питания, салазки (все делаем порт-в-порт для минимизации возможных проблем в будущем).

- Все обязательно маркируется для учета и удобства дальнейшего обслуживания.

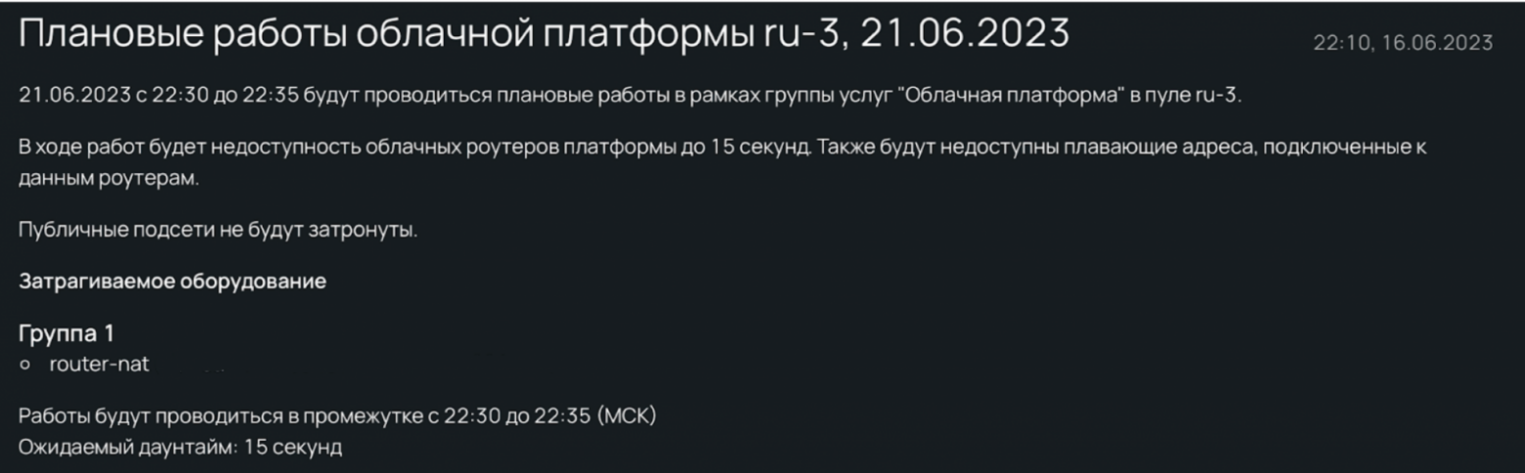

Оповещение

Когда инфраструктура готова, мы информируем клиентов. Инженеры собирают весь список затрагиваемых пользователей и составляют обращение. Только на этом этапе клиенты узнают о том, что планируются работы для улучшения инфраструктуры. Далее на электронную почту, в тикеты и личный кабинет приходит такое уведомление:

Мы всегда прописываем период работ и время даунтаймов. Если речь не идет о критическом сбое, то в обычном режиме уведомление высылается минимум за пять рабочих дней с описанием локации, датой и периодом работ.

Заблаговременное информирование помогает клиентам скорректировать свои планы на время переключений, принать различного рода решения, например, написать в созданный тикет о том, что он не готов выполнять работы по переезду в запланированную дату. В таком случае мы всегда идем навстречу пользователям.

Миграция

Клиенты уведомлены, оборудование проверено несколько раз, все места подготовлены. Начинаем миграцию? Стоп. Не рассказали о самом важном: о людях.

Исходя из объема предстоящих работ, рассчитывается необходимое количество инженеров. Для ускорения работ и мониторинга привлекаются дополнительные специалисты.

Под покровом темноты: что происходит со стороны клиента

В каждом дата-центре ночью дежурит инженер, который следит за охлаждением, инфраструктурой и энергетикой через системы мониторинга, отвечает на тикеты клиентов, делает обходы и выполняет текущие задачи.

Работы по переезду чаще проводятся в ночное время, когда у клиентских сервисов снижается нагрузка. Поскольку такая работа требует максимальной концентрации и внимания, для ее выполнения привлекаются хорошо отдохнувшие инженеры. Начальники смен, на всякий случай, даже не берут одинаковую еду.

Перед началом работ план проговаривается еще раз. Один из дежурных инженеров дата-центра уведомляет дежурных смежных подразделений, которые со своей стороны также дополнительно контролируют процессы и следят за мониторингом:

- Сетевой отдел мониторит статусы портов, собирает данные о доступности платформ.

- Отдел облака перераспределяет нагрузку на резервные серверы, если работы затрагивают их вотчину.

- Энергетики отслеживают показатели утилизации мощности в стойках.

Серверы «мягко» выключаются инженерами, чтобы RAID-массивы синхронизировались, все службы корректно остановились. Клиенты также могут сделать это самостоятельно до начала проведения работ, а также запросить через тикет-систему список серверов, которые будут затронуты в ходе работ.

Затем серверы мигрируют в новую стойку или другое здание. При перемещении платформ между локациями мы уделяем много внимания безопасности (сохранению данных клиентов, бережной транспортировке, соблюдению техники безопасности).

После перемещения серверы монтируются в новую стойку юнит-в-юнит. Это важный момент, так как каждому серверу принадлежат свои порты на сетевом оборудовании и розетки на PDU. При подключении уделяется внимание заранее заготовленным маркировкам — в соответствии с ними производится монтаж.

Если клиент перенес нагрузку на свои серверы, а те, которые мы перевозим, выключил, то каких-то изменений в работе сервисов не будет вовсе. Если инфраструктура проекта состоит из одного сервера, то даунтайма, к сожалению, не избежать.

Когда включаются все серверы, проверяется их доступность и запрашивается подтверждение данных со смежных отделов. Нужно установить, что температура и электроэнергия в норме. После подтверждения информации о доступности всех платформ дежурный уведомляет об окончании переезда.

Заключение

Наша команда постоянно развивается и расширяется, чтобы улучшать рабочие процессы и клиентский опыт. Несмотря на кажущуюся простоту, миграция — это сложный и трудоемкий процесс, а цена ошибки — не только даунтаймы у клиентов, но и репутационные потери. За одним часом миграционных работ стоят недели подготовки, согласований, утверждений и усилий инженеров.