«Аналоговые» спецэффекты

Как нетрудно догадаться, киноиндустрия далеко не сразу пришла к созданию различных эффектов с помощью только железа (процессоры и GPU) и софта. На ранних этапах были задействованы совершенно другие средства: протезы, реквизит, механические устройства, включая аниматронику, и прочее. И эта практика сохраняется до сих пор: нередко компьютерная графика (CGI) — это то, что дополняет «дедовские» методы создания спецэффектов, привнося в фантастический сценарий элемент «осязаемой реальности».

Одним из самых ранних спецэффектов был стоп-трюк, при котором съемка останавливается, а актер или объект появляется или исчезает из сцены. Для зрителя это создавало волшебство, словно человек просто растворялся в воздухе или, напротив, появлялся из ниоткуда. В это же время были разработаны матовые картины — изображения удаленного объекта, нарисованные на стекле — и эффекты грима.

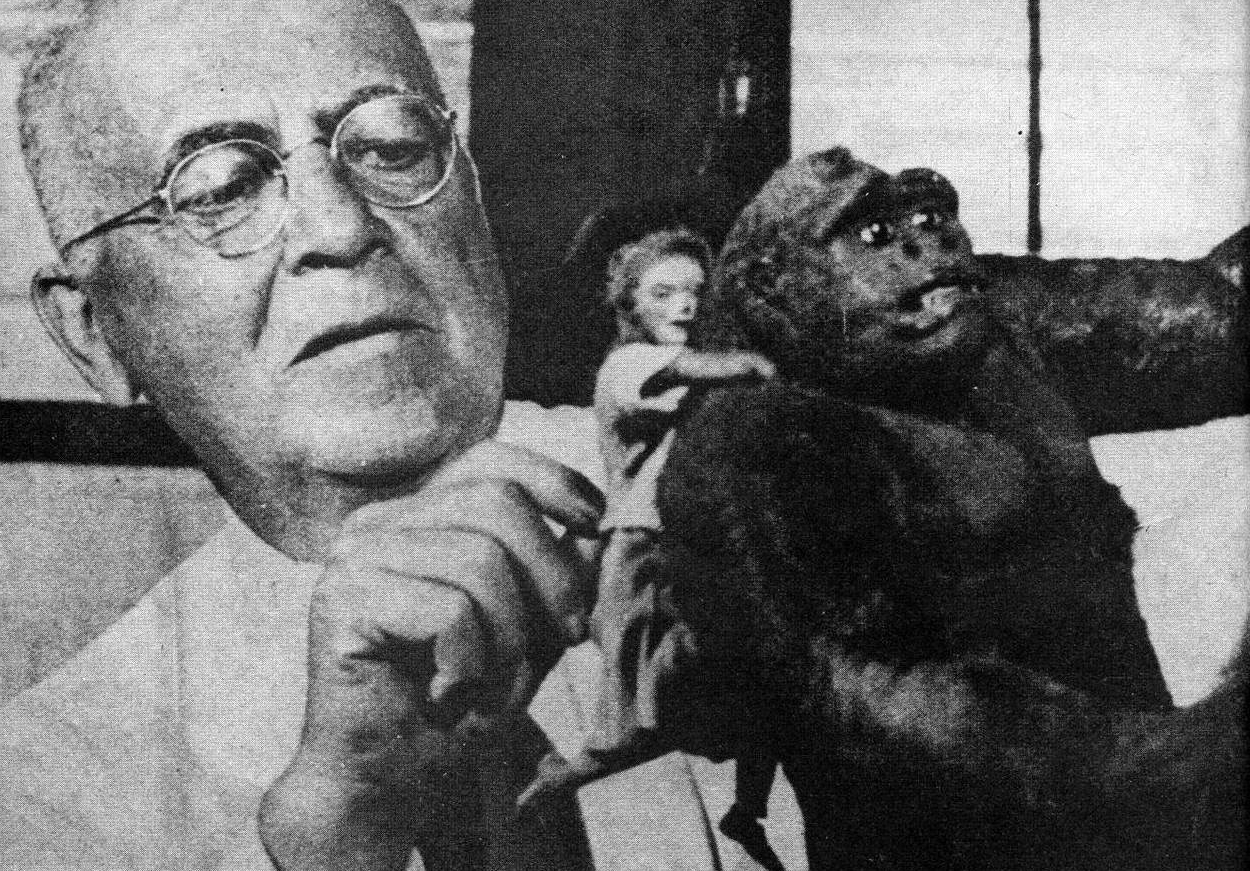

Уже в 1930-х годах голливудские студии создали собственные отделы спецэффектов. А поскольку они конкурировали друг с другом, даже простые технологии вроде использования миниатюр и комбинированных кадров становились все более изощренными. Например, компания RKO Pictures и аниматор Уиллис О’Брайен создали один из самых запоминающихся покадровых анимационных роликов для фильма «Кинг-Конг» в 1933 году.

Ранние спецэффекты были по сути ручной реализацией того, что сегодня решается с помощью софта. Стоп-моушн в «Кинг-Конге» (1933), матт-пейнтинг в «Волшебнике страны Оз» (1939), миниатюры в «Метрополисе» (1927) — все это способы аппроксимации сложных сцен при жестких ресурсных ограничениях.

Каждый кадр требовал детального повторения: камера должна была двигаться одинаково, свет — оставаться неизменным, объекты — строго следовать траектории. Эти задачи позже естественным образом лягут на вычислительные системы, где повторяемость и точность — естественные свойства.

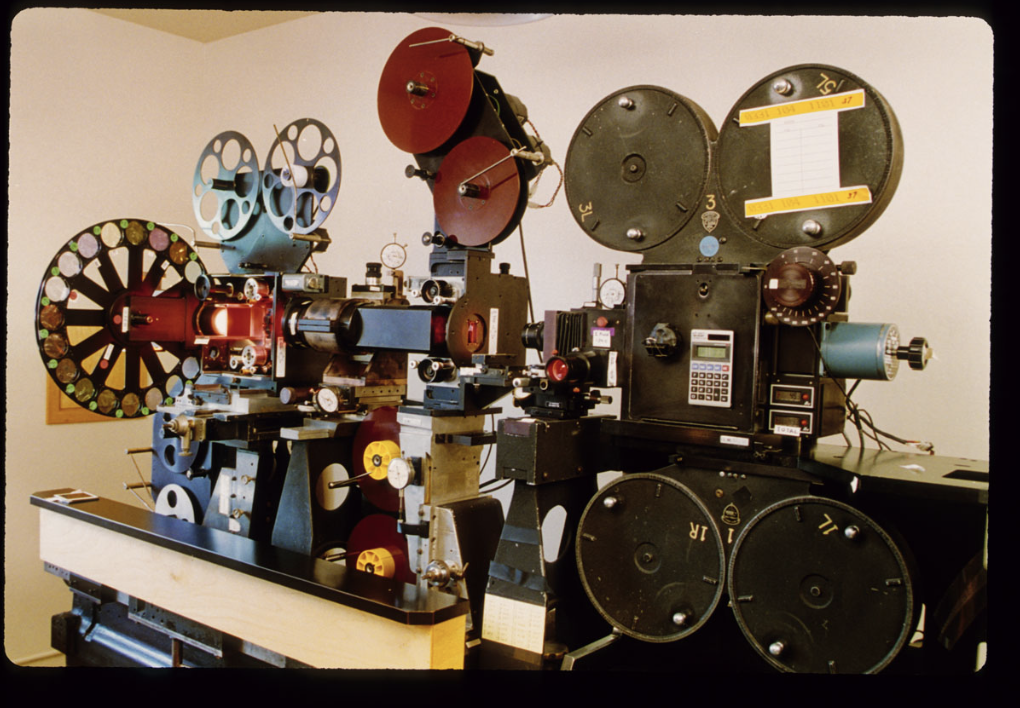

Позже во время Второй мировой войны разработка оптического принтера упростила работу студий по созданию более сложных спецэффектов. Принтер соединял кинокамеру с одним или несколькими проекторами, что позволяло кинематографистам переснимать фрагменты фильма. Оптический принтер создавал комбинированные кадры, затемнения и наложения, а также ускоренное и замедленное движение, часто в рамках одной и той же сцены. Он оставался отраслевым стандартом вплоть до 1970-х годов.

В середине XX века бум научно-фантастических фильмов подтолкнул киноиндустрию к разработке более сложных эффектов. Рэй Харрихаузен в Америке и Эйдзи Цубурая в Японии совершили невероятные прорывы в покадровой анимации, миниатюрах и оптических эффектах в 1950-х и 1960-х годах. Самые новаторские спецэффекты этого периода появились в фильме Стэнли Кубрика «2001: Космическая одиссея» (1968).

Команда режиссера создала впечатляющие миниатюры с помощью управления движением и ротоскопирования, которое включало рисованную анимацию поверх отснятого материала. А для создания иллюзии невесомости в фильме использовали тросы и вращающиеся декорации.

К 1970-м годам кино подошло к пределам аналоговых технологий. Джордж Лукас и Стивен Спилберг значительно продвинули создание фильмов со спецэффектами двумя блокбастерами 1970-х годов: «Звездные войны» и «Близкие контакты третьей степени». Лукас и постановщик визуальных эффектов Джон Дайкстра оптимизировали существовавшие технологии, включая контроль движения — управляемые компьютером камеры, способные воспроизводить движение с субпиксельной точностью. Режиссеры позже сотрудничали в проектах с участием компании Лукаса по спецэффектам, Industrial Light & Magic, которая фактически стала кинолабораторией. Однако вычислительных ресурсов все еще не хватало для полноценной цифровой графики.

Истоки технологии GPU

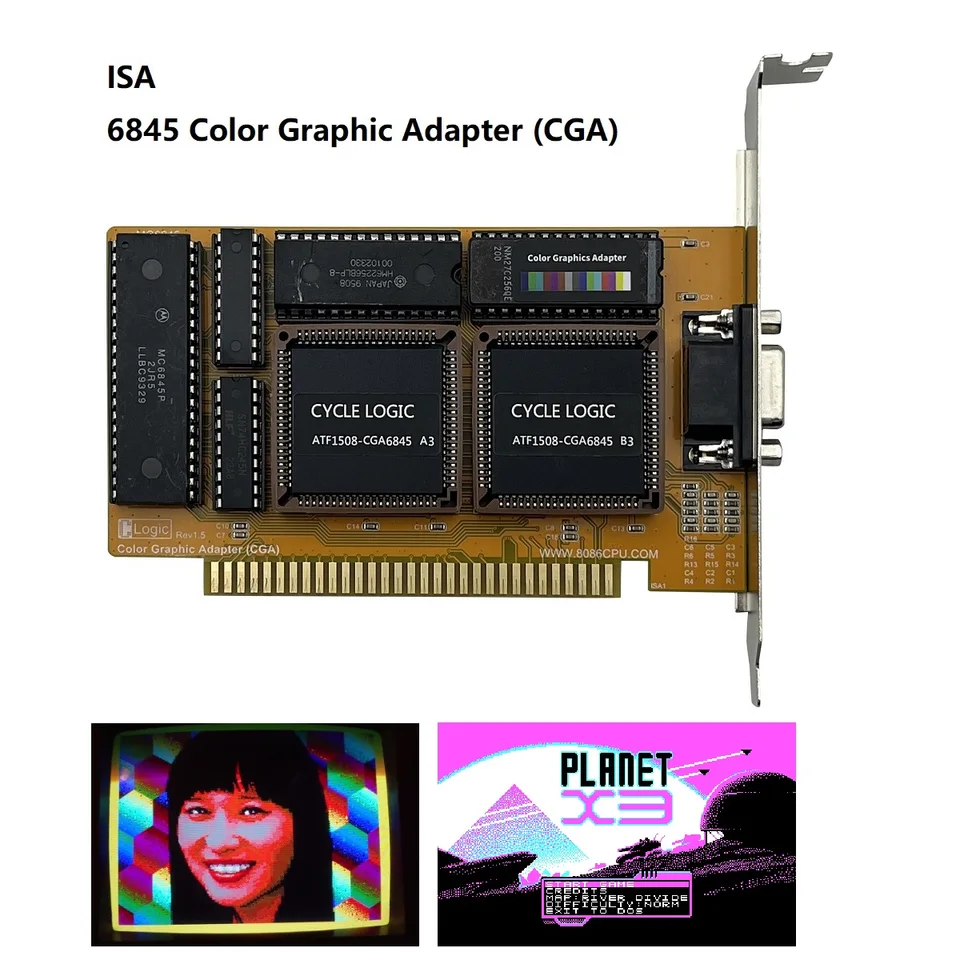

Первые GPU были далеки от тех мощных устройств, которые мы знаем сегодня. В начале 1980-х они в основном использовались для разгрузки центральных процессоров (CPU) от задач рендеринга. В эту эпоху были созданы первые специализированные графические платы, которые в основном использовались в игровых автоматах и домашних компьютерах. Эти ранние GPU отлично справлялись с рисованием простых фигур, их заполнением цветом и обработкой простой анимации, заложив основу для более продвинутых технологий обработки изображений в будущем.

Монохромные дисплеи были нормой, а простые графические процессоры помогали пользователям ориентироваться в зарождающемся мире персональных компьютеров. CGA (Color Graphics Adapter) и EGA (Enhanced Graphics Adapter) были одними из пионеров, заложивших основу для визуальных возможностей будущих систем.

Первые CGI-кадры в «Троне» (1982) и «Терминаторе 2» (1991) создавались на рабочих станциях с крайне ограниченной производительностью. Рендеринг выполнялся на CPU, сцены упрощались, а освещение часто подменялось художественными допущениями. Тем не менее именно в этот период стало ясно, что фотореализм — это вопрос вычислительной мощности.

Кино начинает формировать спрос на специализированное железо, способное выполнять одни и те же операции над тысячами примитивов одновременно.

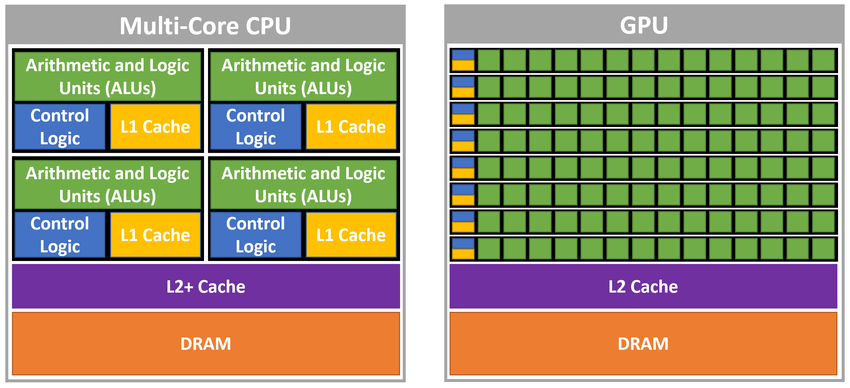

Графический процессор стал ответом на фундаментальную проблему компьютерной графики: массовый параллелизм. В отличие от CPU, оптимизированного под последовательные ветвящиеся задачи, GPU строится вокруг сотен и тысяч простых вычислительных блоков (арифметико-логических устройств, ALU), работающих синхронно. Каждое из них выполняет базовые операции — сложение, умножение, интерполяцию — но делает это одновременно с тысячами других.

Для задач киношного рендеринга это критично. Один кадр — это миллионы вершин, фрагментов, лучей и сэмплов освещения. GPU не «думает» о сцене целиком, он обрабатывает ее как поток однотипных данных. Именно поэтому операции вроде расчета освещения, BRDF-моделей или симуляции частиц масштабируются почти линейно с ростом числа ALU.

CPU здесь проигрывает по архитектуре: его ядра слишком универсальны и плохо загружены при однотипных задачах. А GPU идеально совпал по архитектуре с природой визуальных эффектов. Рендеринг — это массовая, однотипная, параллельная задача с высокой потребностью в пропускной способности памяти. Графические процессоры словно для этого и создавались.

Первые GPU

Идея использования сверхбольшой интеграции и множества ALU принадлежит Генри Фуксу, который в 1981 году предложил проект Pixel Planes в Университете Северной Каролины. Немного позже, в 1995 году, Билл Далли провел фундаментальные исследования в области обработки потоковых данных в Массачусетском технологическом институте в рамках проекта Imagine, а в 1996 году перешел в Стэнфордский университет. Сейчас он является старшим научным сотрудником NVIDIA.

Работа Далли показала, что ряд задач, включая работу с 3D-графикой и обработку видео, могут использовать преимущества эффективности обработки потоковых данных. Это исследование в значительной степени повлияло на развитие технологий: создание GPU от ATI Technologies, а также микропроцессоров Cell от Sony, Toshiba и IBM. Потоковые процессоры, SIMD-процессоры, параллельные процессоры и GPU — все это тесно связанные между собой семейства.

Ранние GPU использовали фиксированный конвейер, но с переходом к программируемым шейдерам (конец 1990-х — начало 2000-х) видеокарта превратилась в универсальный потоковый процессор. Компания TI возглавила парад в 1986 году с процессором TMS34010, а в 1999 году 3Dlabs представила геометрический процессор GLINT — первый графический ускоритель. GLINT ускорял строго определенные операции OpenGL, но не брал на себя полноценные вычисления сцены.

Вскоре после этого NVIDIA выпустила чип NV10, который позднее был представлен рынку как первый графический процессор под коммерческим названием GeForce 256. Следом и ATI представила свой VPU, который был попыткой предложить ту же технологию, но под другим названием. К этому времени TI уже исчезла с рынка, не желая продолжать инвестировать в исследования и разработку в области графики — шаг, о котором, скорее всего, компания много раз жалела.

NVIDIA NV10 и последующие архитектуры закрепили модель, в которой сцена разбивается на огромные массивы данных, обрабатываемых параллельно. Для кино это означало революцию: освещение, тени, отражения, симуляции частиц и жидкости перестали быть абстрактными эффектами и стали вычислимыми задачами.

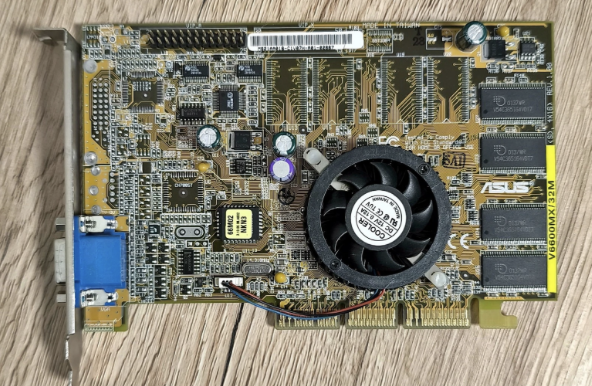

В 1990-х годах, по мере развития видеоигр и компьютерной графики, рос и спрос на более мощные возможности рендеринга. Этот период ознаменовал появление 3D-графического ускорения, изменившего возможности GPU. Потребность в более захватывающих игровых процессах и реалистичных симуляциях стимулировала разработку видеокарт, способных рендерить трехмерные среды. Такие компании, как 3dfx Interactive и NVIDIA, сыграли ключевую роль в этом переходе.

Выпуск видеокарты Voodoo от 3dfx в 1996 году стал важной вехой, предоставив аппаратное ускорение 3D-рендеринга широкому кругу потребителей. Чип работал на частоте 50 МГц и обеспечивал производительность до 50 миллионов текстурированных пикселей в секунду (50 Mpixels/s), что на порядки превосходило программный рендеринг на CPU того времени. Поддержка Z-буферизации и билинейной фильтрации на аппаратном уровне позволила резко снизить нагрузку на процессор и обеспечить стабильные 30–60 кадров в секунду в играх, которые ранее с трудом запускались даже в низком разрешении.

Следующий качественный скачок произошел с выходом уже упомянутой NVIDIA GeForce 256 в 1999 году — первой видеокарты, официально позиционируемой как GPU. При частоте до 120 МГц и пропускной способности памяти порядка 4,8 ГБ/с, GeForce 256 могла обрабатывать до 15 миллионов полигонов в секунду благодаря аппаратной реализации Transform & Lighting (T&L). Это означало, что матричные преобразования вершин и расчет освещения, ранее выполнявшиеся центральным процессором, полностью переносились на видеочип, освобождая десятки процентов CPU-времени.

В результате производительность в 3D-сценах возрастала в 2–4 раза по сравнению с видеокартами без аппаратного T&L, а разработчики получили возможность использовать более сложные модели с тысячами полигонов, динамические источники света и анимацию без критического падения FPS. Именно этот сдвиг — от ускорения растеризации к полноценной геометрической обработке — подготовил основу для современной 3D-графики в играх и киноиндустрии, где рост реализма стал напрямую зависеть от вычислительных возможностей GPU, а не CPU.

Заря цифровых эффектов

Ключевым моментом в эволюции GPU стало появление универсальных вычислительных API, прежде всего CUDA. GPU перестал быть устройством исключительно для графического конвейера и стал использоваться как полноценный вычислительный ускоритель.

В Стэнфорде была опробована и успешно реализована идея потоковых вычислений с использованием графических процессоров ATI, хотя программирование через OpenGL оказалось сложным. Для преодоления этого препятствия NVIDIA разработала язык параллельной обработки, похожий на C, известный как CUDA. Год спустя Apple и Khronos представили OpenCL. К 2006 году параллельная обработка на графическом процессоре утвердилась как новая парадигма с огромным потенциалом. Везде, где приложение нуждалось в параллельной обработке, начинали развиваться вычисления на GPU.

В прошлом параллельная обработка осуществлялась с помощью огромного количества процессоров x86, но они были очень дорогими и сложными в программировании. GPU же как специализированный процессор с одной целью предлагал гораздо большую вычислительную мощность. Впоследствии именно он стал использоваться во многих задачах ускорения математических вычислений — графические процессоры стали иметь решающее значение для высокопроизводительных вычислений, суперкомпьютеров и искусственного интеллекта.

Но причем тут киноиндустрия? Ей это тоже оказалось выгодно, поскольку дало возможность:

- писать собственные симуляции физики, дыма, жидкости;

- ускорять рендеринг path tracing;

- внедрять нейросети прямо в пайплайн постпродакшена.

CUDA, OpenCL, Vulkan Compute и другие технологии позволили студиям оптимизировать рендеринг под конкретные сцены и задачи. Фактически каждая крупная VFX-студия сегодня имеет собственный набор вычислительных инструментов, заточенных под GPU.

Кластерное решение

Фактически киноиндустрия стала крупным потребителем высокопроизводительных вычислений, наряду с наукой, финансовым сектором и игровой индустрией. А один современный фильм — это миллионы кадров, которые требуют часов рендеринга.

Крупные киностудии хотят абсолютного контроля над качеством изображения — они одержимы пикселями. Требуемый уровень детализации делает создание убедительных визуальных эффектов очень сложным. Одна из самых распространенных жалоб от художников касается виртуальной воды. Очень сложно создать компьютерную графику воды так, чтобы она не выглядела как желе.

По сути, визуальный стиль современных фильмов во многом формируется не только художественными решениями, но и ограничениями SIMD-архитектуры. GPU использует модель SIMD (Single Instruction, Multiple Data), а в более современных терминах — SIMT (Single Instruction, Multiple Threads). Это означает, что одна инструкция применяется сразу ко множеству данных. В контексте рендеринга это выглядит естественно: один и тот же шейдер исполняется для тысяч пикселей или лучей.

Эта модель отлично подходит для визуальных эффектов, но накладывает ограничения. Ветвления, условные операторы и сложная логика резко снижают эффективность. Именно поэтому киношные шейдеры и симуляции стремятся к максимальной предсказуемости и минимизации дивергенции потоков.

Предсказуемость симуляции — это ситуация, когда поведение вычислений заранее известно и одинаково для большого количества элементов сцены. В контексте GPU это означает:

- один и тот же код,

- одни и те же шаги вычислений,

- минимальное количество условий «если… то…»,

- одинаковая нагрузка для всех потоков.

Например, сцена с дождем — это 10 миллионов капель, каждая из которых движется по одной формуле и с одинаковым числом вычислительных шагов. Это идеальный сценарий для GPU: все ALU загружены равномерно, каждая капля — отдельный поток.

Но что если часть капель сталкивается с объектами, часть испаряется, часть меняет поведение из-за ветра, а часть вообще пропадает? Код становится непредсказуемым: одни капли заставляют вычислять одно, вторые — другое, третьи вообще выходят из симуляции. GPU не любят непредсказуемость.

А дивергенция потоков — главный враг SIMD. Она возникает, когда параллельные потоки, которые должны выполнять одну инструкцию, начинают идти по разным веткам кода. И это действительно проблема. Как уже сказано, GPU работает по модели SIMD / SIMT: одна инструкция — множество данных.

Но в коде может быть, скажем, вот такое условие:

if (surface == water) {

calculate_refraction();

} else if (surface == metal) {

calculate_reflection();

}

Тогда часть потоков считает воду, часть — металл, часть вообще ничего. GPU вынужден выполнять все ветки по очереди, просто маскируя ненужные потоки. В итоге ALU простаивают, производительность падает, а эффективность параллелизма резко снижается. Это и есть дивергенция потоков.

Поэтому в киношной графике симуляции стараются делать максимально однородными, даже если реальность сложнее:

- вода часто считается как единый объем, а не как отдельные капли;

- дым — как поле плотности, а не набор частиц;

- разрушения — заранее подготовленные фрагменты, а не полностью динамическая физика.

Это неизбежное архитектурное упрощение. Если бы киноиндустрия с ним не согласилась, мы вряд ли увидели бы все эти потрясающие сцены со спецэффектами из фильмов.

И даже такое «упрощение» представляет собой основную проблему для студий визуальных эффектов. Так появляются рендер-фермы и GPU-кластеры. Например, студия Untold работала над серией рекламных роликов для Суперкубка, что требовало огромных вычислительных мощностей. Это были пять масштабных рекламных роликов со спецэффектами, для которых требовалось много вычислительных ресурсов, и все они должны были быть готовы в один день.

Обычно Untold работает над множеством проектов одновременно, но они, как правило, находятся на разных этапах разработки и не требуют одинакового объема вычислительных ресурсов. В случае с Суперкубком ситуация была иной. Студия подсчитала, что для рендеринга всех пяти рекламных роликов на одной рабочей станции художника потребовалось бы 138 лет. Вместо этого, используя AWS, Untold смогла задействовать до 1 470 узлов EC2, чтобы выполнить работу за день.

Или другой пример — анимационный фильм «Нэчжа 2», где отдельные сцены требовали квинтиллионов операций в секунду, а объем данных одного кадра достигал сотен гигабайт. Такие задачи решаются исключительно за счет параллельной обработки на тысячах GPU. Рендеринг этих сложных сцен задействовал 40% вычислительной мощности Гуйаньского суперкомпьютерного центра в провинции Гуйчжоу на юго-западе Китая.

Для создания чешуи дракона в фильме требовалось 12 слоев рендеринга материалов, пиковая вычислительная мощность составляла три квинтиллиона операций в секунду, а объем данных одного кадра достигала 800 гигабайт.

В районе Гуйань провинции Гуйчжоу на сегодняшний день построено 23 дата-центра, что делает его одним из регионов с самыми богатыми внутренними ресурсами в области интеллектуальных вычислений. Гуйаньский суперкомпьютерный центр участвовал в рендеринге более 50 фильмов и телесериалов с 2020 года. Имея 1 000 высокопроизводительных GPU и более 600 серверов, он в настоящее время может похвастаться суммарной вычислительной мощностью в 15 квадриллионов вычислений в секунду, что недостижимо для обычных персональных компьютеров.

Тем не менее, рост мощности GPU не вытеснил практические эффекты, а изменил их роль. В фильме «Начало» (2010) Кристофер Нолан сознательно ограничил использование CGI, комбинируя его с реальными декорациями. В «Дюне» (2021) Дени Вильнева цифровая графика используется как продолжение физического мира, а не его замена.

Сериалы вроде «Мандалорца» идут еще дальше: GPU рендерят окружение в реальном времени на LED-экранах прямо во время съемки. Это прямое заимствование игровых технологий, где вычисления происходят с минимальной задержкой.

Оскар за GPU

Современные GPU все чаще используются не только для рендеринга, но и для машинного обучения. Нейросети применяются для шумоподавления, апскейлинга, генерации текстур и ускорения постпродакшена. GPU перестает быть «графическим» устройством в узком смысле. Это универсальный вычислительный инструмент, который формирует будущее визуальных медиа.

Исследования NVIDIA в области ИИ-рендеринга были отмечены научно-техническими наградами Американской киноакадемии. На протяжении последних 17 лет технологии NVIDIA работали за кулисами каждого фильма, номинированного на премию «Оскар» за лучшие визуальные эффекты.

В 2025 три исследователя NVIDIA — Эссекс Эдвардс, Фабрис Руссель и Тимо Айла — были удостоены научных и технических наград Академии кинематографических искусств и наук за их новаторский вклад в киноиндустрию.

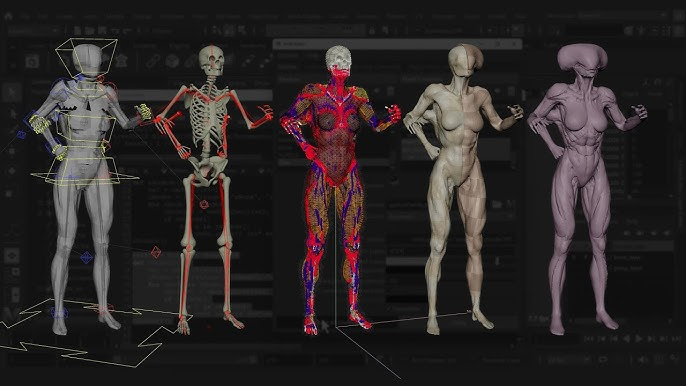

Эссекс Эдвардс получил награду за технические достижения вместе с Джеймсом Джейкобсом, Йернеем Барбичем, Кроуфордом Дораном и Эндрю ван Стратеном за разработку и создание Ziva VFX. Эта система позволяет художникам создавать и моделировать человеческие мышцы, жир, фасции и кожу для цифровых персонажей с помощью интуитивно понятного подхода, основанного на физике.

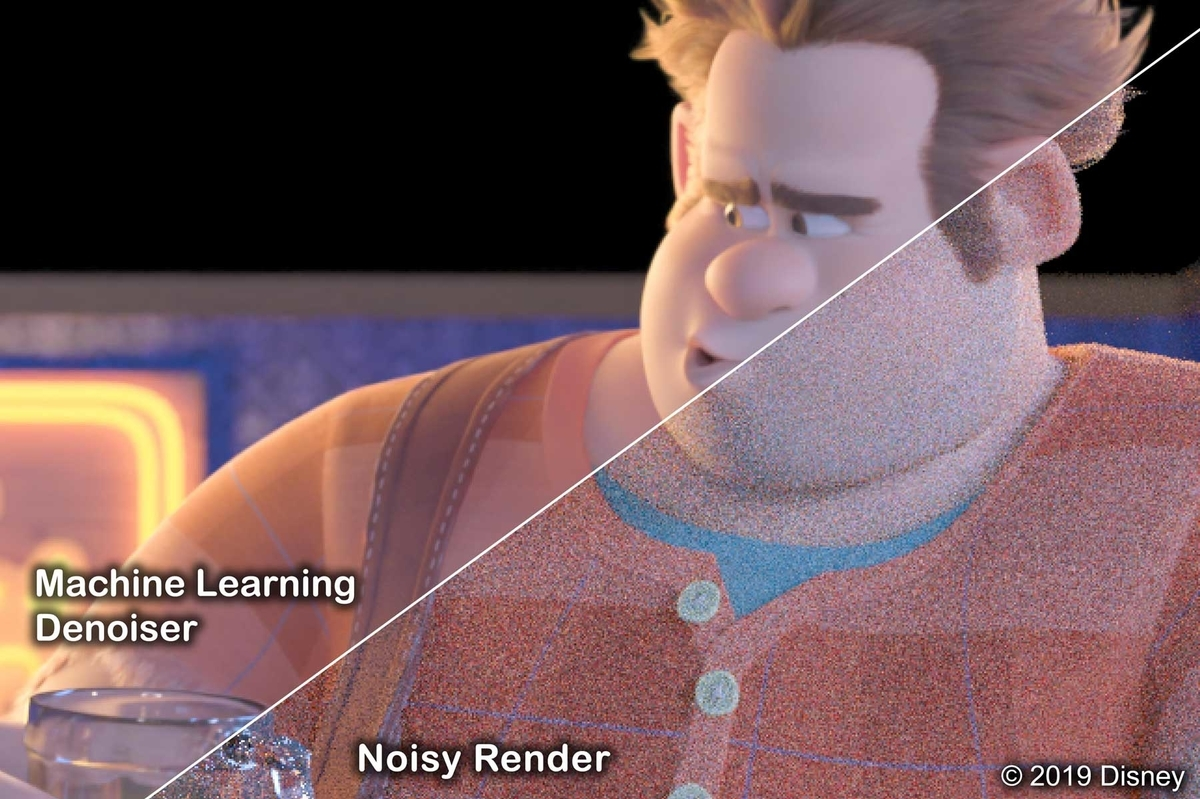

Фабрис Руссель был удостоен награды за научные и инженерные достижения вместе с Тейсом Фогельсом, Дэвидом Адлером, Герхардом Ретлином и Марком Мейером за свою работу над технологией шумоподавления Disney на основе машинного обучения (Disney ML Denoiser). Эта технология обеспечивает временную стабильность в отрендеренных изображениях для более высокого качества графики.

Первоначально разработанная для повышения качества анимационных фильмов, эта технология с тех пор стала незаменимым инструментом в визуальных эффектах для игрового кино и высокопроизводительных рабочих процессах рендеринга. Она помогает удалять шум, повышать резкость изображений и ускорять рендеринг, позволяя художникам работать быстрее, достигая при этом более высокого качества.

Этот шумоподавитель был разработан исследовательским центром Disney, студией ILM, студиями Pixar и Walt Disney Animation — результат масштабных межстудийных усилий, призванных расширить границы визуального повествования для студий по всей индустрии. С 2018 года технология шумоподавления использовалась более чем в 100 фильмах, включая «Историю игрушек 4», «Ральф ломает интернет» и «Мстители: Финал».

Тимо Айла получил награду за технические достижения вместе с Аттилой Афра за свой новаторский вклад в шумоподавление изображений с помощью ИИ. Айла руководил ранней разработкой архитектуры U-Net, которая доказала свою способность удалять шум, сохраняя при этом мелкие детали, и стала жизненно важной технологией в киноиндустрии. Афра реализовал ее в Intel Open Image Denoise, популярной библиотеке с открытым исходным кодом для высококачественного шумоподавления с помощью ИИ. U-Net также стала важной технологией в других алгоритмах шумоподавления для кино, включая NVIDIA OptiX Denoiser.

За прошедшие годы еще 15 исследователей NVIDIA были удостоены научных и технических наград, отражающих значительный вклад NVIDIA в искусство и науку кинематографии благодаря передовым исследованиям в области искусственного интеллекта, моделирования и рендеринга в реальном времени.

Заключение

Современные спецэффекты в кино редко воспринимаются как технологическое достижение — зритель видит результат, но редко задумывается о вычислительной инфраструктуре, которая стоит за каждым кадром. Между тем именно развитие GPU и серверных вычислений стало ключевым фактором эволюции визуальных эффектов.

История киношной графики — это не только история режиссерских идей и художественных приемов, но и история архитектурных решений в железе, от первых фиксированных конвейеров до современных GPU-кластеров и ИИ-ускорения. Сегодня именно эти технологии определяют границы возможного в кино, делая GPU незаметным, но полноправным со-продюсером современных фильмов.

Графический процессор претерпел значительную трансформацию с момента своего появления. Первоначально разработанный для ускорения создания изображений в буфере кадров, предназначенном для вывода на дисплей, GPU стал ключевым элементом в решении множества сложных вычислительных задач. Этот эволюционный путь от простых устройств рендеринга видео до сложных процессоров искусственного интеллекта подчеркивает не только технологические достижения, но и сдвиги в вычислительных парадигмах.